Category: X-Review

Paper, Conference, Seminar, API, Code, Dataset 등의 리뷰를 담을 예정입니다.

[arxiv 2025] Vision Language Models are Biased

Video를 위한 RAG를 구축하기 위해서는 VLM 모델 활용이 필수적입니다. 그러나 최근 몇 연구에서는 VLM이 데이터에 대한 이해능력에 대해 의혹을 제기하고 있는데요, 해당 논문을 통해 VLM에게…

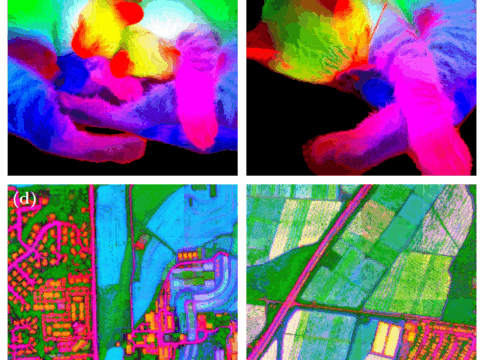

[ICCV 2025] Selective Contrastive Learning for Weakly Supervised Affordance Grounding

Abstrcat 물체와의 상호작용을 위해서는 상호작용이 이루어지는 영역에 대하여 알아야 합니다. weakly-supervised affordance grounding(WSAG)은 사람의 학습 방식을 모방하여 제 3자가 물체와 상호작용하는 영상을 통해 픽셀 수준의…

[arXiv 2025] OpenHelix: An Open-source Dual-System VLA Model for Robotic Manipulation

이번 리뷰 논문은 VLA 논문으로 가장 핫한 트렌드인 Dual-system VLA에 대한 꼼꼼한 분석을 하고 분석 결과를 토대로 SOTA를 달성한 기법 입니다. 지속적으로 분석과 공유를 할…

[arXiv 2024] PriorDiffusion: Leverage Language Prior in Diffusion Models for Monocular Depth Estimation

안녕하세요, 76번째 x-review 입니다. 이번 논문은 2024년 11월 arXiv에 올라온 PriorDiffusion이라는 논문 입니다. 그럼 바로 리뷰 시작하겠습니다 1. Introduction Monocular Depth Estimation(MDE)는 최근 diffusion 기반의…

DINOv3

이번에 소개드릴 논문은 최근에 공개된 DINOv3 입니다. DINOv2가 CV에서 엄청난 파급력이 있음은 잘 알려져있지만 그렇다고 이번에 새로 나온 DINOv3 논문 제목이 추가적인 부연 설명이나 내용…

[CVPR 2025] Question-Aware Gaussian Experts for Audio-Visual Question Answering

안녕하세요. 오늘의 X-Review에서는 25년도 CVPR에 게재된 <Question-Aware Gaussian Experts for Audio-Visual Question Answering> 논문을 소개드리겠습니다. CVPR 리뷰 과정에서 좋은 평가를 받아 Highlight으로 선정된 논문입니다. 1….

[ICCV 2023] Audio-Enhanced Text-to-Video Retrieval using Text-Conditioned Feature Alignment

오랜만에 Text-to-Video Retrieval (VTR) 연구에 대해 리뷰해보려고 합니다. 최근 비디오에 포함되어 있는 ‘오디오’라는 모달리티를 활용하는 연구로도 지속적인 관심이 생겨나고 있는 것 같은데, VTR에서는 어떻게 연구가…

[ICCV 2025] RoBridge: A Hierarchical Architecture Bridging Cognition and Execution for General Robotic Manipulation

안녕하세요. 이번엔 VLM high-level planning과 RL+IL의 low-level execution 간의 각각의 장단점을 보완해서 중간에 저자들이 제안한 symbolic bridge 방식으로 안정적으로 통합하는 general manipulation 프레임워크를 들고 왔습니다….

[2025 arXiv] TEACH: TEXT ENCODING AS CURRICULUM HINTS FOR SCENE TEXT RECOGNITION

1. INTRODUCTION Scene Text Recognition은 이미지에서 텍스트를 읽어내는 태스크로 Optical Character Recognition (OCR)의 하위 범주에 속합니다. 문서 속 텍스트를 읽는 document OCR과 비교했을 때 더…

[CVPRW2024]ViTA: An Efficient Video-to-Text Algorithm using VLM for RAG-based VideoAnalysis System

안녕하세요, 오늘 소개드릴 논문은 비디오 modality를 위한 RAG 프레임워크를 제안한 논문입니다. RAG의 기본적인 동작 도메인인 텍스트 도메인보다 데이터 용량이 큰 비디오 도메인을 다루는 만큼, 효율성을…

안녕하세요 재윤님, 좋은 리뷰 감사합니다. 텍스트와 시각 정보를 선택적으로 집중하고, 적절한 시간의 지식만을 효과적으로 사용하기 위한 방법론이라고 이해했습니다. episodic /…