안녕하세요 손우진입니다.

이번주에도 graphics 논문을 리뷰 해보려고합니다. 요즘은 열화상 이미지와 RGB 이미지를 3DGS novel-view-synthetics 로 두 카메라를 픽셀 level에서 alignment를 맞추는 작업을 하고 있는데요. 로봇팔을 이용해 데이터를 수집하는 환경이라 두 카메라의 위치와 자세는 정확히 알고 있는 상황입니다. 다만 그렇다고 해서 정렬이 바로 해결되는 문제는 아니었습니다. 두 이미지간의 정렬 자체는 생각보다 까다로운 작업이었고, 여러 번의 시행착오와 삽질을 거친 끝에 결국 맞출 수 있었습니다. 일단 픽셀 level에서 alignment는 되는 상태까지는 왔지만, 그 다음 단계에서 또 다른 문제가 드러났습니다.

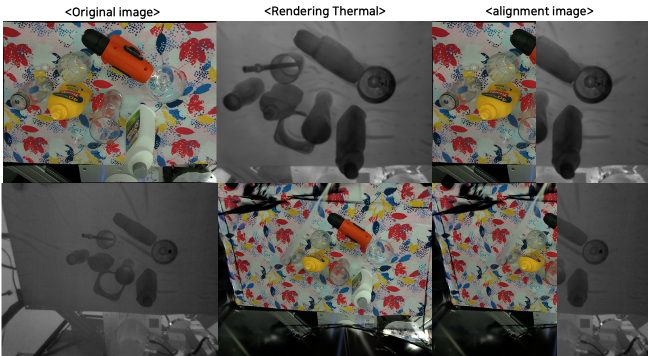

위 이미지는 제가 rendering을 통해 alignment를 맞춘 이미지인데요 RGB 시점으로 열화상을 렌더링 할때는 이미 관측했던 영역들이라 비교적 렌더링이 잘 됩니다.하지만 열화상 시점에서 RGB를 렌더링하려고 하면 제한되는 점이 생기는데요. 열화상 카메라는 RGB카메라에 비해 시야각이 넓다 보니, RGB에서 보지 못한 영역이 자연스럽게 생기게 되고, 이 영역의 끝부분에서는 hole이 발생하거나 artifact가 남아서 이미지의 품질이 크게 저하되는 현상이 나타납니다. 이 문제는 픽셀 정렬이 틀린 것이 아니라 두 카메라의 시야각과 관측 범위가 다르다는 구조적인 차이에서 비롯된 문제입니다.

여기서 중요한 점은, 이 작업에서 굳이 두 시점을 모두 고려해야 하는 이유입니다. 제가 만들고 싶은 것은 특정 시점에서만 잘 맞는 결과가 아니라, RGB와 열화상이 서로 보완되는 상황을 포함하는 데이터셋입니다. 예를 들어 RGB에서는 연기나 조명 변화 같은 환경에서 관측이 어려운 경우가 있고, 이런 상황에서는 열화상이 더 안정적으로 관측할 수 있습니다. 반대로 열화상에서는 투명한 통 안에 있는 물체처럼 관측이 잘 되지 않는 상황이 있지만, RGB에서는 충분히 정보를 얻을 수 있는 경우도 있습니다.

이런 상호보완적인 상황들을 데이터셋에 포함시키고, 그 위에서 다양한 실험이나 추가적인 연구를 하려면 어느 한쪽 시점에만 맞춘 결과로는 부족합니다. 두 카메라 시점 모두에서 동일한 영역이 일관되게 렌더링될 수 있어야 하고, 시야각 차이로 인해 한쪽 시점에서만 hole이나 artifact가 생기는 구조는 결국 한계로 남게 됩니다.

그래서 이번에 리뷰할 논문에서는 이러한 문제를 다룬 논문입니다. 기존 시점을 유지한 채 관측 영역의 외곽을 확장하는 방법을 통해 sparse-view 3D 재구성에서 발생하는 hole과 artifact를 줄이려는 시도입니다. 이 접근이 현재 제가 겪고 있는 열화상–RGB 멀티모달 alignment 문제에서 해결 할 수있지않을까 생각되어 리뷰해봅니다. 서론이 너무 길었네요 한번 어떻게 해결하는지 가볍게 리뷰 해보도록 하겠습니다.

Introduction

이 논문은 제한된 수의 입력 시점으로 3차원 장면을 재구성하는 sparse-view 3D reconstruction 문제를 다룹니다. 이러한 환경은 그래픽스와 비전 전반에서 자주 등장하고 입력 데이터가 충분하지 않은 상황에서도 일관된 3D 재구성을 만드는 것이 중요한 과제로 여겨져 왔습니다. 이를 위해 기존 연구들에서는 정규화 기법이나 semantic prior, 기하학적 제약 등을 활용해 sparse-view 문제를 완화하려는 시도들이 이어져 왔습니다.

최근에는 diffusion 모델을 활용해 sparse-view 문제를 해결하려는 접근들이 주목을 받았습니다. 입력 시점이 적다면 새로운 시점을 생성해 뷰의 개수를 늘리고 이를 통해 3D 재구성 품질을 향상시키려는 방향입니다. 이러한 diffusion 기반 novel view generation 방식은 이미지 생성 관점에서는 그럴듯한 결과를 보여주었고, sparse-view 환경에서도 성능이 좋아진 것처럼 보이는 사례들을 만들어냈습니다.

하지만 이 논문에서는 이러한 기존 접근들이 가지는 한계를 명확하게 정리합니다. 저자들은 diffusion 기반 novel view generation이 sparse-view 3D 재구성에서 다음과 같은 세 가지 근본적인 한계를 가진다고 설명합니다.

첫째, 새로운 시점을 생성하는 방식은 기존에 관측된 기하 구조의 각도적 커버리지를 늘리는 데에는 효과적이지만, 시야 바깥의 미관측 영역을 실제로 확장하는 데에는 한계가 있습니다. 그 결과 재구성 결과의 외곽에는 hole이나 경계 artifact가 지속적으로 남게 됩니다.

둘째, diffusion 모델의 확률적 특성으로 인해 생성된 새로운 시점들과 입력 시점들 사이에서 기하적·광학적 불일치가 발생하며, 시점 간 중첩이 늘어날수록 이러한 불일치는 3D 공간에서 ghosting이나 geometry inconsistency로 증폭됩니다.

셋째, novel view generation 방식은 카메라 궤적 설계와 포즈 샘플링이 필수적이어서 파이프라인이 복잡해지고, 전체 재구성 과정이 시간 소모적으로 변합니다.

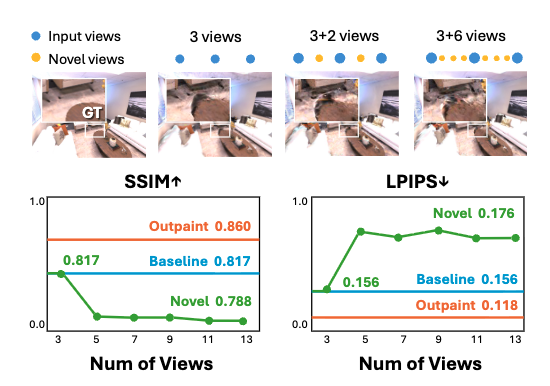

이러한 한계는 Figure 2에서 직관적으로 드러납니다. Figure 2에서는 multi-view diffusion 모델을 사용해 생성한 novel view의 개수를 늘려가며 3DGS 재구성 결과를 비교하는데, 새로운 시점을 추가할수록 오히려 재구성 품질이 저하되는 현상이 관찰됩니다. 입력 시점을 3개에서 11개까지 늘릴 경우, 기하적 정확도(SSIM)와 지각적 품질(LPIPS) 모두가 악화되며, 이는 생성된 시점들 사이의 불일치와 artifact가 3D 재구성 과정에 그대로 누적되기 때문임을 보여줍니다. 즉, sparse-view 문제에서 핵심은 시점의 개수가 아니라, 기하적으로 일관된 관측 범위를 어떻게 확보하느냐라는 점을 강조합니다.

이러한 관찰을 바탕으로 저자들은 novel view generation 대신 outpainting을 sparse-view 3D 재구성을 위한 대안적인 패러다임으로 제안합니다. 새로운 카메라 포즈를 생성하는 대신, 기존 입력 시점을 유지한 채 관측 영역의 외곽을 확장함으로써 hole과 artifact를 줄일 수 있다는 관점입니다. Figure 2에서도 확인할 수 있듯이 동일한 조건에서 outpainting을 적용한 경우에는 시점 수를 늘리지 않고도 더 안정적인 재구성 품질을 유지한다고합니다.

논문에서 저자들이 제시한 Contribution을 정리하면 다음과 같습니다.

- sparse-view 3D 재구성 문제에서 outpainting을 novel view generation보다 우수한 패러다임으로 정립하고, hole, ghosting artifact, 그리고 기하적 불일치와 같은 대표적인 문제들을 효과적으로 완화할 수 있음을 보였습니다.

- geometry-aware outpainting 접근법을 제안하며, 새로운 conditioning 방식과 denoising 전략을 통해 추가적인 fine-tuning 없이 zero-shot 방식으로 동작하는 diffusion 기반 outpainting 방법을 설계했습니다.

- Replica와 ScanNet++ 데이터셋을 대상으로 3, 6, 9개의 입력 시점 설정에서 실험을 수행하여, 기하적 정확도와 지각적 품질 모두에서 state-of-the-art 성능을 달성했으며, 재구성 시간을 10분 이내로 줄여 기존 video diffusion 기반 방법 대비 큰 속도 향상을 확인했습니다.

Method

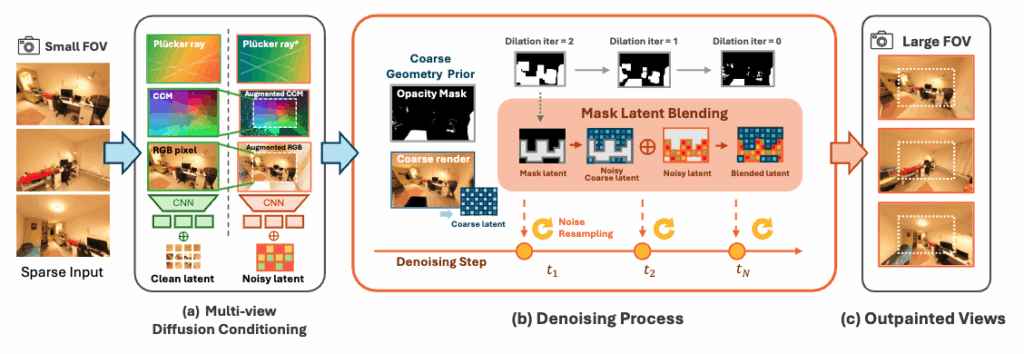

위 그림은 전체 파이프라인의 overview를 보여줍니다. 입력 이미지의 시야각(FOV)을 확장함으로써 기존 이미지를 수정하지 않으면서도 hole을 채우고, 흐릿한 경계를 보정하며, 기하학적 일관성을 보존할 수 있습니다. 이를 통해 보다 단순하고 빠른 3D 재구성 프로세스를 얻는 것이 이 방법의 핵심입니다. 본 파이프라인은 세 가지 단계로 구성됩니다. 먼저 기하학적 사전 정보를 얻기 위한 초기 3D 초기화 단계, 다음으로 확대된 FOV 뷰를 생성하는 기하학 인식 다중 뷰 아웃페인팅 단계, 마지막으로 아웃페인팅된 뷰를 활용해 재구성 품질을 향상시키는 정제된 3D 재구성 단계입니다.

Coarse 3D Initialization

초기 단계에서는 DUSt3R를 통해 sparse input view로부터 3D point를 추정하고, 이를 기반으로 3D Gaussian Splatting(3DGS)을 사용해 장면을 초기값으로 재구성합니다. 이때 얻어지는 결과는 시각적으로 완성도가 높은 3D가 아니며, 논문에서는 이를 coarse render I_{\text{coarse}} 로 표기합니다. 이 단계의 목적은 고품질 재구성이 아니라, outpainting이 필요한 영역을 기하적으로 식별하기 위한 사전 정보를 얻는 것입니다.

초기 3DGS로부터 각 입력 시점에 대해 I_{\text{coarse}}와 함께 opacity mask를 추출합니다. opacity mask는 각 픽셀이 현재 3D 재구성으로 설명 가능한 영역인지를 나타내며, 이를 통해 기존에 관측된 영역과 비어 있는 영역을 구분할 수 있습니다. 논문에서는 이 마스크를 dilation하여, outpainting이 적용될 영역을 보다 안정적으로 정의합니다.

또한 논문에서는 입력 이미지의 시야각을 확장하기 위해 카메라 포즈는 유지한 채 내부 파라미터만 조정합니다. 구체적으로는 focal length를 scaling하여 동일한 시점에서 더 넓은 FOV를 갖는 뷰를 정의합니다.

카메라 내부 파라미터 K가 주어졌을 때, 확장된 FOV에 해당하는 내부 파라미터 K’는 다음과 같이 해석할 수 있습니다.

여기서 s는 scaling ratio로, focal length를 줄임으로써 동일한 카메라 시점에서 관측 범위를 확장합니다. 중요한 점은 이 과정이 새로운 카메라 포즈를 생성하는 것이 아니라, 기존 시점에서 시야각만 확장한다는 것입니다. 정리하면, Coarse 3D Initialization 단계는 I_{\text{coarse}}와 opacity mask, 그리고 확장된 내부 파라미터를 통해 outpainting이 수행될 영역을 기하적으로 정의하는 준비 단계라고 볼 수 있습니다.

GaMO: Geometry-aware Multi-view Diffusion Outpainter

이 단계에서는 앞서 얻은 기하학적 사전 정보와 확장된 시야각(FOV)을 바탕으로 diffusion을 이용한 outpainting을 수행합니다. 이 방법의 핵심은, diffusion이 단순히 이미지를 보고 생성하는 것이 아니라, 각 픽셀에 대응되는 카메라 ray를 조건으로 사용해 생성한다는 점입니다. 즉, GaMO에서 outpainting은 이미지 공간이 아니라 ray 공간을 기준으로 이루어집니다.

앞 단계에서 정의한 확장된 내부 파라미터를 통해, 동일한 카메라 시점에서 더 넓은 FOV를 갖는 타깃 뷰가 정의됩니다. 이때 확장된 FOV의 각 픽셀에 대해, 해당 픽셀이 3D 공간에서 어떤 방향을 바라보는지를 나타내는 Plücker ray가 계산됩니다. 이 ray 정보는 diffusion 모델의 핵심 조건으로 사용되며, 생성 과정 전반에서 픽셀과 3D 공간 사이의 기하적 대응 관계를 유지하는 역할을 합니다.

Outpainting 과정에서 diffusion 모델은 여러 조건을 함께 입력으로 받습니다. 대표적으로 확장된 FOV에 대한 Plücker ray, 초기 3D 재구성으로부터 얻은 coarse render I_{\text{coarse}}, 그리고 opacity mask가 사용됩니다. 이 중에서도 ray 정보는 “이 픽셀이 어느 방향의 3D 공간을 보고 있는가”를 명시적으로 제공함으로써, diffusion이 공간적으로 말이 되는 내용을 생성하도록 강하게 제약합니다.

생성은 확장된 FOV 전체를 대상으로 정의되지만, 실제로 diffusion이 작동하는 영역은 opacity mask에 의해 제한됩니다. 즉, 기존 3D 재구성으로 설명 가능한 영역은 그대로 유지되고, opacity가 낮아 현재 3D로는 커버되지 않는 영역에 대해서만 outpainting이 수행됩니다. 이를 통해 diffusion이 이미 관측된 영역을 다시 그리거나 왜곡하는 것을 방지합니다.

논문에서는 diffusion denoising 과정 중 특정 step에서 mask latent blending을 적용해, 생성 중인 latent와 coarse geometry로부터 얻은 latent를 결합합니다. 이 과정은 다음과 같이 표현됩니다.

z_{s-1} \leftarrow \mathcal{M} \odot z_{s-1}^{\text{coarse}} + (1 - \mathcal{M}) \odot z_{s-1}여기서 \mathcal{M}은 opacity mask(또는 dilation된 마스크)를 의미합니다. 이 연산을 통해 outpainting 영역에서는 coarse geometry가 지속적으로 반영되고, diffusion이 ray 조건과 기하 구조에서 크게 벗어나는 결과를 생성하지 않도록 합니다.

정리하면, GaMO의 outpainting은 확장된 FOV에서 각 픽셀에 대응되는 ray를 기준으로, coarse 3D geometry와 opacity mask를 함께 조건으로 사용해 수행됩니다. 이로 인해 GT가 없는 영역에 대해서도 무작위적인 상상이 아니라, 기하적으로 제한된 범위 내에서의 보완적인 생성이 가능해집니다.

3DGS Refinement with Outpainted Views

앞 단계에서 생성된 outpainted views와 원본 input views를 함께 사용하여 3D Gaussian Splatting(3DGS) 모델을 정제합니다. 이때 outpainted view는 새로운 카메라 시점이 아니라, 기존 입력 시점과 동일한 카메라 포즈에서 시야각만 확장된 이미지이므로, 별도의 카메라 포즈 추정 없이 기존 파라미터를 그대로 사용합니다.

학습 과정에서는 매 iteration마다 input view 또는 outpainted view 중 하나를 샘플링하여 supervision으로 사용합니다. 두 종류의 뷰는 성격이 다르기 때문에, 서로 다른 손실 함수를 적용해 3DGS를 최적화합니다.

입력 뷰(input view)에 대해서는 실제 관측된 이미지가 ground truth로 존재하므로, 기존 3DGS에서 사용되는 표준 재구성 손실을 그대로 적용합니다. 즉, 렌더링된 이미지와 입력 이미지 사이의 L1 손실과 구조적 유사도(D-SSIM)를 결합한 손실을 통해 관측된 영역의 정확한 재구성을 유도합니다.

반면 outpainted 뷰는 diffusion 모델을 통해 생성된 이미지로, 실제 관측된 ground truth가 존재하지 않습니다. 단순한 재구성 손실만 사용할 경우 비관측 영역이 충분히 채워지지 않거나 artifact가 발생할 수 있기 때문에, 논문에서는 perceptual loss(LPIPS)를 추가로 사용합니다. 이를 통해 outpainted 영역과 기존 관측 영역 모두에서 균형 잡힌 gradient를 제공하고, 시각적으로 일관된 방향으로 3DGS가 정제되도록 합니다.

정리하면, 입력 뷰는 기존 3DGS와 동일한 재구성 손실로 학습하고, outpainted 뷰는 ground truth가 없기 때문에 perceptual loss를 추가해 시각적으로 일관된 방향으로 3DGS를 정제합니다. 이 과정을 통해 초기 재구성 단계에서는 관측되지 않았던 시야 외곽 영역까지 3DGS가 커버할 수 있게 되며, wide-FOV 렌더링 시 발생하던 hole과 경계 artifact가 효과적으로 감소합니다

Experiments

실험의 핵심 목적은 기존 diffusion 기반 novel view generation 방식과 비교했을 때, 기존 시점을 유지한 채 시야각을 확장하는 outpainting 기반 접근이 재구성 품질과 일관성 측면에서 어떤 차이를 만들어내는지를 확인하는 데 있습니다.

실험은 Replica와 ScanNet++ 데이터셋을 대상으로 진행되며 입력 시점 수를 3, 6, 9개로 제한한 sparse-view 설정을 사용합니다. 이는 실제 환경에서 촬영 시점이 제한되는 상황을 가정한 설정으로, 본 논문이 다루는 문제와 직접적으로 연결됩니다. 모든 비교 실험에서는 동일한 초기 조건을 유지한 채, 입력 뷰만 사용하는 baseline, diffusion 기반 novel view를 추가하는 방식, 그리고 제안하는 GaMO 방식을 비교합니다.

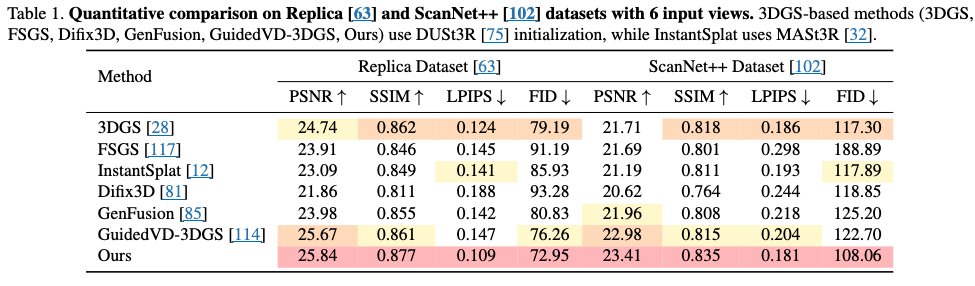

Table 1은 Replica와 ScanNet++ 데이터셋에서 입력 시점 6개를 사용했을 때의 정량적 성능 비교 결과를 보여줍니다. 비교에 포함된 대부분의 3DGS 기반 방법들은 동일하게 DUSt3R 초기 3D 포인트를 사용하여 초기화를 수행하며, 초기화 방식에 따른 차이는 최소화되어 있습니다.

이러한 동일 조건 하에서 GaMO는 두 데이터셋 모두에서 PSNR과 SSIM이 가장 높고, LPIPS와 FID가 가장 낮은 성능을 기록합니다. 특히 diffusion 기반 novel view generation을 사용하는 GuidedVD-3DGS와 비교했을 때, GaMO가 더 높은성능을 보입니다. 이 실험은 기존 시점을 유지한 채 관측 범위를 확장하는 outpainting 기반 접근 자체의 효과임을 보여줍니다. sparse-view 환경에서 새로운 시점을 추가하는 방식보다, 기하적으로 일관된 관측 확장이 더 안정적인 재구성을 가능하게 한다는 점을 정량적으로 뒷받침합니다.

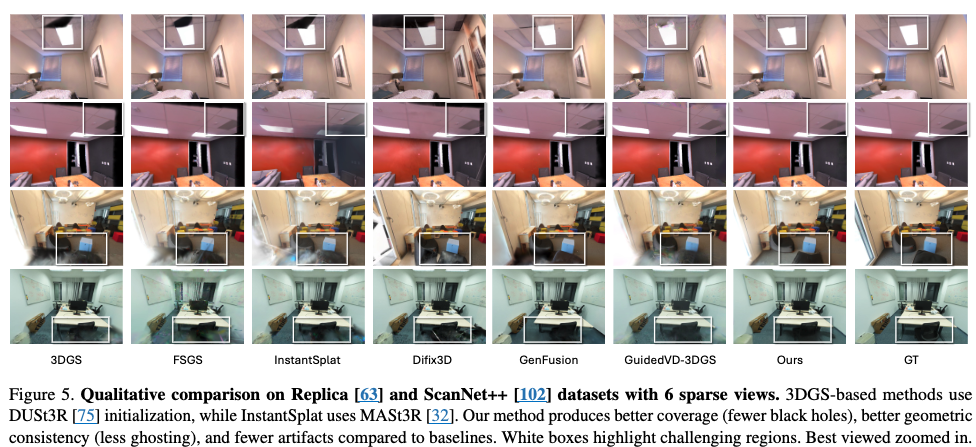

기존 3DGS, FSGS, Difix3D, GenFusion 등의 방법들은 장면 외곽이나 시야가 확장되는 영역에서 black hole이 남거나, 경계 부근에서 artifact가 발생하는 모습을 보입니다. diffusion 기반 novel view generation을 사용하는 GuidedVD-3DGS 역시 일부 영역에서는 구조가 채워지지만, 뷰 간 불일치로 인해 ghosting이나 불안정한 패턴이 관찰됩니다.

반면 GaMO(Ours)는 기존 시점을 유지한 채 시야각을 확장하는 outpainting 방식을 사용하기 때문에, 장면 외곽까지 비교적 자연스럽게 채워진 결과를 보여줍니다. 흰색 박스로 표시된 영역을 보면, 다른 방법들에 비해 black hole이 현저히 줄어들고, 기하 구조가 보다 일관되게 유지되는 것을 확인할 수 있습니다. 특히 경계 부근에서의 ghosting과 구조 붕괴가 감소한 점이 두드러집니다.

이러한 정성적 결과는 Table 1에서 확인한 LPIPS와 FID 개선이 단순한 수치상의 차이가 아니라, 실제로 시각적으로도 더 안정적인 재구성 결과로 이어진다는 점을 보여줍니다. 즉, GaMO는 sparse-view 환경에서 관측되지 않은 영역을 무작위로 생성하기보다, 기하적으로 일관된 방식으로 보완하는 데 성공한 것으로 볼 수 있습니다.

Ablation Study

앞서 방법론에서 설명한 바와 같이, GaMO는 coarse geometry, opacity mask, 그리고 ray 기반 기하 조건을 결합해 outpainting을 수행합니다.

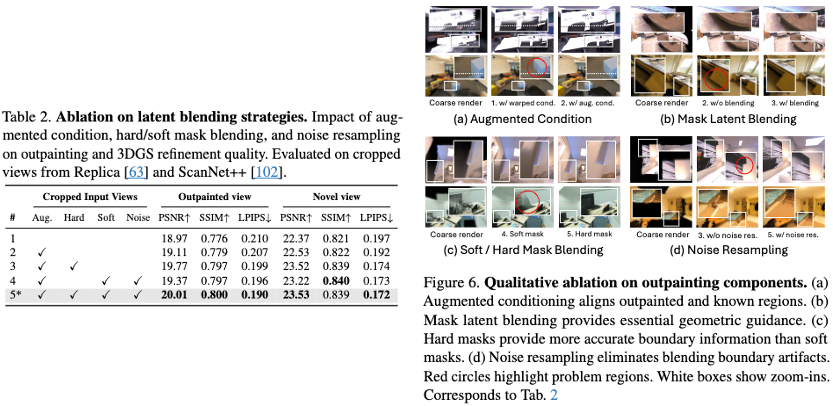

먼저 geometry-aware conditioning이 없는 경우, 확장된 FOV 영역에서 생성된 결과가 기존 관측 영역과 잘 정렬되지 않으며 구조적인 불안정성이 발생합니다. 반면, 각 픽셀에 대응되는 카메라 ray를 조건으로 사용하면 outpainted 영역과 기존 영역 사이의 기하적 정합이 눈에 띄게 개선됩니다. 이는 앞서 설명한 ray 기반 생성이 단순한 이미지 조건보다 중요한 이유를 시각적으로 보여줍니다.

다음으로 opacity mask를 이용한 latent blending의 효과를 확인할 수 있습니다. mask를 사용하지 않을 경우 diffusion이 기존 관측 영역까지 다시 생성하면서 구조 왜곡이 발생하지만, opacity mask를 통해 outpainting 영역을 제한하면 coarse geometry가 유지되며 보다 안정적인 결과를 얻을 수 있습니다. Figure 6에서는 mask 적용 여부에 따라 경계 부근의 결과가 어떻게 달라지는지가 명확히 드러납니다.

마지막으로 noise resampling은 mask 기반 blending 과정에서 발생할 수 있는 경계 artifact를 완화하는 역할을 합니다. resampling을 적용하지 않은 경우 경계가 부자연스럽게 남는 반면, 이를 적용하면 outpainting 영역과 기존 영역 사이의 전이가 보다 자연스럽게 정리됩니다.

종합하면, ablation 결과는 GaMO의 성능 향상이 단일 기법에서 비롯된 것이 아니라, ray 기반 기하 조건, opacity mask를 통한 영역 제약, 그리고 생성 안정화를 위한 resampling이 함께 작동한 결과임을 보여줍니다.

Conclusion

GaMO는 새로운 카메라 시점을 생성하는 대신, 기존 시점을 유지한 채 시야각만 확장하고, 그 과정에서 ray 기반 기하 조건과 opacity mask를 통해 생성 범위를 강하게 제한하는 접근을 제안합니다.

이러한 점이 RGB와 열화상처럼 시야각과 관측 특성이 다른 센서를 함께 사용하는 환경에서도, 한쪽 시점에서만 발생하는 미관측 영역을 보완하는 데 활용 가능성이 있어 보입니다. 특히 wide-FOV 렌더링 시 발생하던 경계 artifact를 줄이고, 두 시점 모두에서 일관된 이미지를 얻고자 하는 현재 제 연구 목표와 직접적으로 맞닿아 있습니다.

향후에는 이 논문의 outpainting 방식을 참고해, 열화상–RGB 멀티모달 설정에서 동일 시점 기반 FOV 확장과 기하 제약을 적용하는 방향으로 실험을 진행해볼 예정입니다.

캄사합니다