안녕하세요, 오늘 리뷰할 논문은 Active Video Perception(AVP)입니다. Long Video Understanding 연구로 기존의 agentic 파이프라인의 단점을 보완한 연구입니다.

Introduction

긴 비디오 이해(Long Video Understanding, LVU)는 대부분 불 필요한 내용으로 구성되어 있는 긴 분량의 비디오 속에서 흩어진 단서들을 찾아서 질문에 대답을 해야하는 도전적인 task입니다. Multimodal Large Language Model(MLLM)의 발전으로 인해 시각 인식 능력은 향상되었지만, 긴 영상을 dense하게 처리하는 것은 계산 비용이 높을 뿐만 아니라 대부분의 시각 토큰이 중복적이고 불필요하기 때문에 복잡한 질문에서의 처리 능력이 떨어지게 됩니다. 질문과 관련있는 단서는 보통 짧고 국지적으로 존재하는데, 긴 시퀀스를 전부 처리하게 되면 그 속에서 중요한 단서가 희석되거나 간과되기 때문입니다. 저자는 따라서 높은 계산 비용, 캡션을 통한 부정확한 단서 연결 문제를 해결하기 위해서 Active Video Perception(AVP)를 제안합니다. 저자는 사람이 긴 영상을 검사하는 방식에서 영감을 받아 모든 프레임을 보지 않고 질문의 유형에 따라 관찰 계획을 세웁니다. 예를 들어 특정 줄거리와 관련된 질문이라면 우선 영상을 대략적으로 훑고 줄거리의 위치를 파악한 뒤에 관련된 부분을 집중적으로 파악합니다. 이러한 행동은 능동 지각 이론으로 정형화될 수 있는데 간단하게 설명하면 Agent는 왜 감지해야하는 지를 이해하고무엇을 어떻게 언제 어디서 감지할지를 스스로 판단한다는 것입니다. 저자는 이것을 LVU에도 동일하게 적용하여 질문에 기반하여 계획을 수립하고 시각적으로 정렬된 관찰을 통해서 무엇을 언제 어디서 볼지 결정하고 증거가 충분한지 판단합니다.

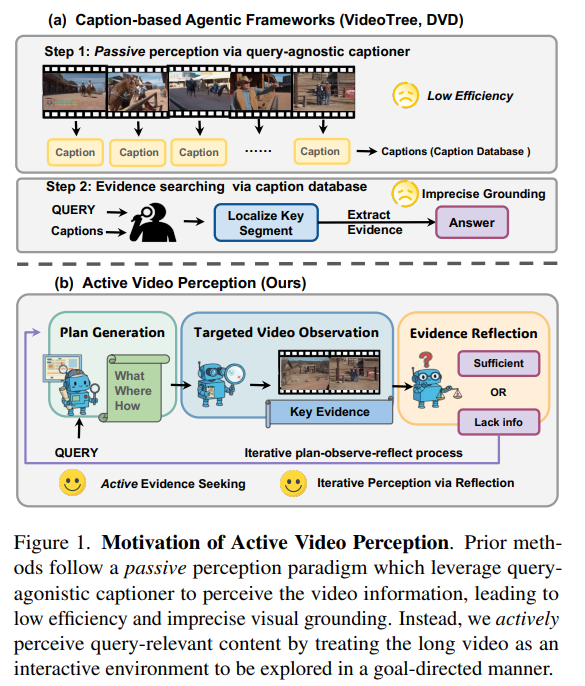

Figure 1은 저자들이 제안하는 AVP의 motivation을 설명하는 그림입니다. 기존 방법들은 수동적인 인지 패러다임을 따르며 질문과는 무관한 여러 영상 전반을 captioning하여 정보를 파악하기에 비효율적이고 부정확한 단서들을 연결하게 됩니다. 하지만, AVP는 질문과 관련된 콘텐츠를 적극적으로 탐색하기 위해 긴 영상을 목표 지향 상호작용 환경으로 간주하여 필요한 부분만 관찰합니다. What, Where, How 등의 질문을 보고 Planning을 통해 목표로 하는 영상을 관찰하고 반성 단계를 통해 단서가 충분한지, 충분하지 않은지를 판단합니다. 이러한 계획, 관찰, 반성을 반복하여 능동적으로 단서를 탐색합니다.

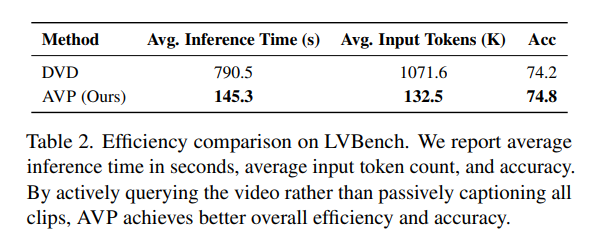

저자는 AVP의 성능과 효율성을 다섯개의 벤치마크에서 검증합니다. MINERVA, LVBench, VideoMME, MLVU, LongVideoBench 데이터셋에서 평가하며 5개의 벤치마크 모두 긴 비디오 이해에서 많이 벤치마킹되는 데이터셋입니다. 저자는 AVP가 기존 SOTA 방법론인 DVD에 비해 약 5.7%의 성능 향상을 보이면서도 추론시간을 18.4%를 단축했으며 입력토큰은 DVD의 12.4%만을 사용한다는 사실을 강조합니다.

Method

AVP는 반복적인 증거 탐색 에이전트 프레임워크로 능동 지각(active perception) 개념에서 영감을 받아 고안되었습니다. 핵심 아이디어는 인공 지능 에이전트가 긴 비디오를 잘 이해하기 위해서는 반복적으로 무엇을, 어디서, 어떻게 영상과 상호작용할지를 이전 관찰에 기반하여 핵심 증거를 찾아야한다는 아이디어입니다.

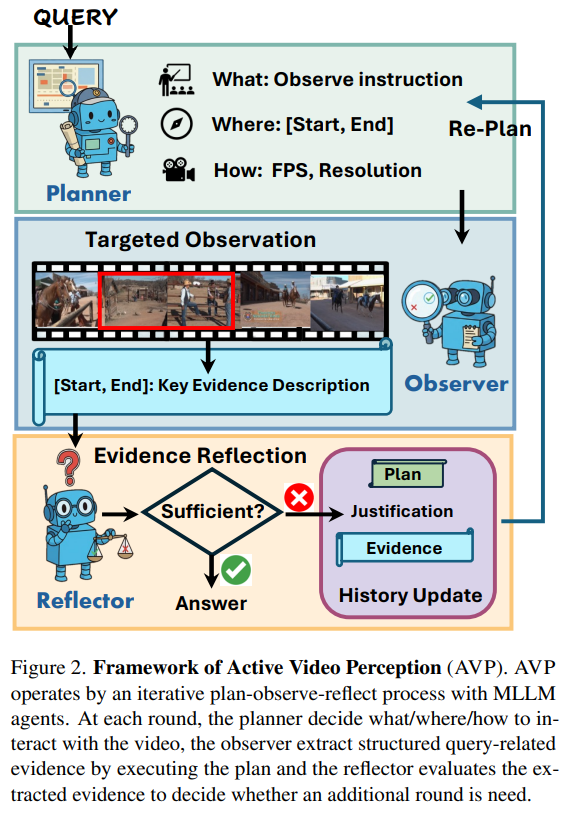

Figure 2는 AVP의 프레임워크를 보여주는 그림입니다. AVP는 MLLM 에이전트들로 구성된 반복적인 계획, 관찰, 반성(reflection) 루프를 통해 동작합니다. 각 회차마다 Planner가 What(무엇), Where(어디서), How(어떻게) 영상과 상호작용할지를 결정하고, Observer는 그 계획에 따라 구조화된 질문과 관련된 증거를 영상 구간에서 추출합니다. Reflector는 추출된 증거를 평가하여 추가적인 회차가 필요할지를 결정합니다. 만약에 Reflector가 질문을 답하기에 충분한 증거가 모였다면(Sufficient), 답변을 생성(answering)하고, 만약에 증거가 불충분하다면, 다시 Planning으로 돌아가 필요한 증거를 더 수집합니다. 이러한 루프는 중요 구간에 계산을 집중시키고 애매한 구간을 재검토하며 길고 복잡한 영상을 이해하는데에 적응적으로 자원을 배분합니다.

Query-Conditioned Query Planning

앞서 AVP는 능동 지각 개념에 착안하여 계획을 먼저 세운다고 설명했었습니다. 구체적으로 AVP는 Planner를 통해 무엇(what)을 찾을지, 어디(where)를 볼지, 어떤(how) 방식으로 볼지를 결정하여 주어진 질문에 대답을 합니다. 먼저 질문 Q와 비디오 V가 주어지면 Planner가 구체적인 관찰을 위한 P^{(1)}=(what^{(1)}, where^{(1)}, how^{(1)})를 생성합니다. 위의 1은 첫번째 회차임을 알려줍니다.

What은 찾아야할 핵심 증거를 간략하게 기술합니다. 만약에 여러 단계를 요구하는 복잡한 질문의 경우에는 Planner가 첫 단계만 계획한 후 이후 절차는 이후의 Planner에게 맡깁니다. 이렇게 복잡한 질문을 쪼개서 접근하는 것으로 Multi-hop 혹은 시간적으로 넓은 범위에 존재하는 증거 탐색을 수행합니다.

Where은 대상 시간 구간 [t_s, t_e]으로 관찰할 영상의 범위를 지정합니다. 범위는 질문 Q에 명시적으로 시간 정보가 있다면 그 구간으로 하고, 만약에 아니라면 영상 전체를 저비용으로 훑으며 대략적인 증거를 수집합니다. 이후에는 Reflector의 피드백에 따라 범위를 조절하며 점진적으로 국소화하며 coarse-to-fine 방식으로 세분화합니다.

How는 샘플링의 granularity를 결정합니다. 기본적으로 coarse부터 fine하게 내려가며, where과 마찬가지로 낮은 비용으로 영상 전반을 탐색하고 반복하며 세분화합니다.

Targeted Video Observation

Planner가 계획을 생성하면, Observer가 계획을 실행하여 자세한 영상을 수집합니다. 구체적으로 회차 r에서 계획P^{(r)} = (\textit{what}^{(r)}, \textit{where}^{(r)}, \textit{how}^{(r)})이 주어지면 Observer는 질문 Q와 what 지침, 그리고 명시된 where 시간 정보와 샘플링전략 how를 이용하여 동작합니다. 구조화된 시간 정보가 포함된 증거 목록E=\{([start_i, end_i], d_i)\}^N_{i=1}을 생성합니다. 여기서 d_i는 시간 구간 내 시각적 사건을 간결하게 묘사한 질문 관련된 설명입니다. 이러한 증거 묘사는 매 회차마다 누적되어 증거리스트 E에 추가됩니다. 이 방법을 통해 질문과 관련된 구간만 파악할 수 있으며 이는 효율적이고 중복되는 정보를 처리하지 않는다는 장점이 됩니다.

Evidence Reflection and Re-Planning

관찰 후에 AVP는 Reflector 에이전트를 사용하여 누적된 증거가 충분한지를 판단하고 추가 관찰이 필요할지를 결정합니다. 만약에 확신도가 부족하다면 다음 회차를 위한 피드백을 제공합니다.

Evidence Reflection: 회차 r에서 질문 Q와 관련된 증거 리스트 E를 입력받아서 Reflector는 질문에 대한 신뢰도 점수 C^{(r)}와 근거에 기반한 설명 J^{(r)}를 생성합니다. C^{(r)}는 질문에 답을 할 수 있을 지를 판단하는 자신감 수준을 나타내는 점수이고 J^{(r)}는 현재 증거들로 생성할 수 있는 답 혹은 부족한 정보를 서술합니다. 만약에 C^{(r)}가 임계치 이상이면 J^{(r)}는 답변이 되고, 이하라면 어떤 정보가 부족한지를 적어서 다음 회차를 위한 피드백을 줍니다.

History Update and Re-Planning : 임계치 미만일때는 Reflector는 현재 회차의 내용과 설명을 히스토리 H에 추가합니다. 이 히스토리에는 무엇을 이미 살펴봤고, 무엇이 확인되었으며, 무엇이 해결되지 않았는지에 대한 요약을 제공합니다.

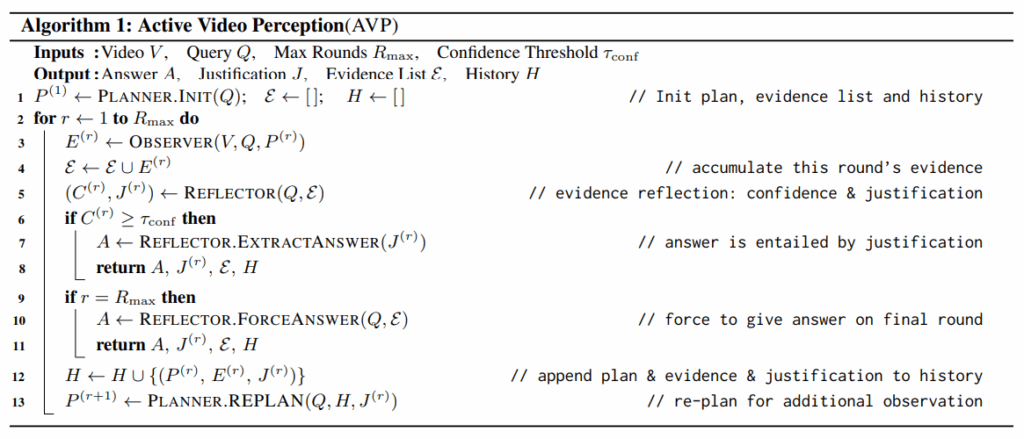

위 알고리즘은 이러한 AVP의 작동방식을 수식적으로 보여줍니다.

Experiments

AVP는 총 5개의 긴 비디오 이해 벤치마크에서 평가합니다.

MINERVA : 사람이 직접 선정한 1515개의 긴 영상으로 구성되어있으며 영상의 평균 길이는 12분입니다.

LV-Bench : 총 103시간 분량의 영상이 존재하는 데이터셋으로 객관식 질문 1549개로 구성되어 있습니다.

MLVU : test셋을 사용하여 2700개의 질문을 사용하고, 평균적으로 15분의 길이의 영상으로 구성되어 있습니다.

VideoMME : 짧은 영상과 긴 영상이 같이 존재하는 데이터셋으로 2700개의 QA를 진행합니다. 이중 900개의 QA는 평균 41분의 긴 영상입니다.

LongVideoBench : referred reasoning 질문을 평가하는 데이터셋으로 1337개의 QA가 존재하고 영상을 15~60분의 길이를 갖습니다.

평가지표는 모두 정확도를 사용합니다.

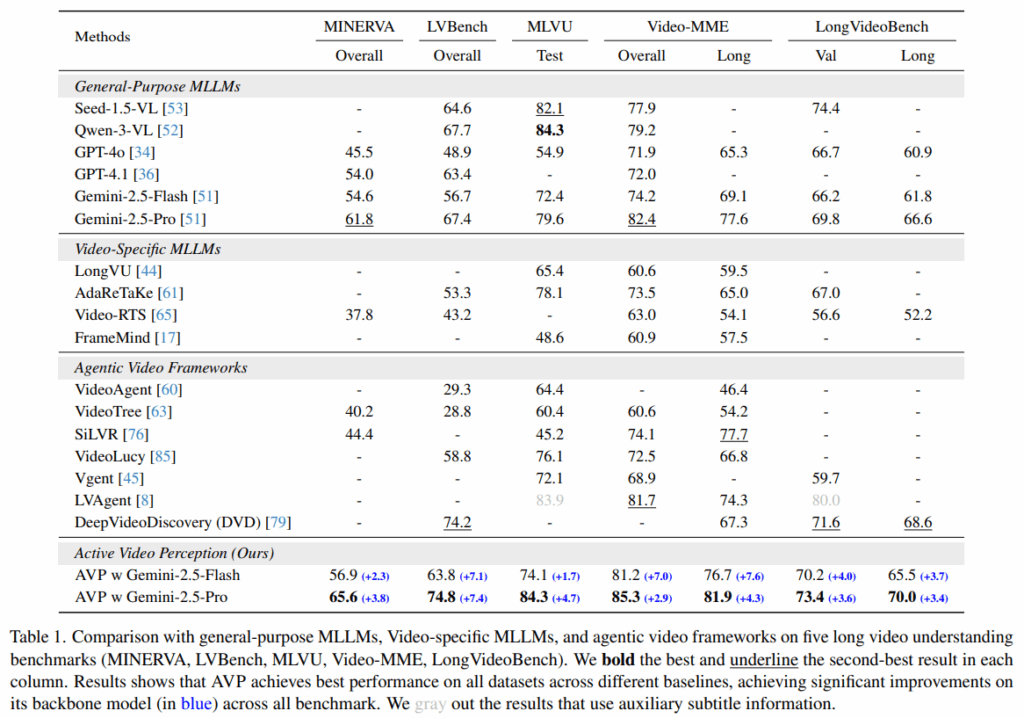

AVP는 5개의 데이터셋 모두에서 제일 높은 성능을 보여줍니다. 기본적으로 Gemini-2.5-Pro모델을 사용하고 Flash 성능도 같이 공개합니다. 저자는 공정한 비교를 위해 최대 입력 토큰의 최대 길이를 128K로 설정하였습니다.

table2는 기존 SOTA모델인 DVD와의 효율성을 비교하는 표입니다. DVD에 비해 훨씬 효율적임을 저자는 강조하고 있습니다. DVD는 오프라인으로 DB를 생성하고 QA를 진행하는 방법론이라 공정한 비교인지는 잘 모르겠지만, AVP가 효율적이긴한것 같습니다.

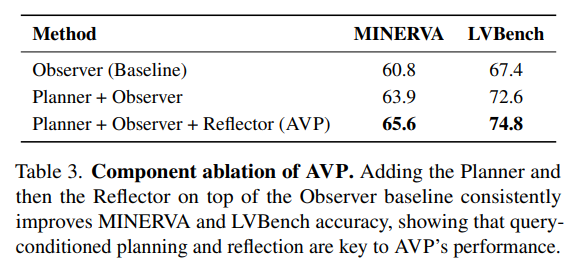

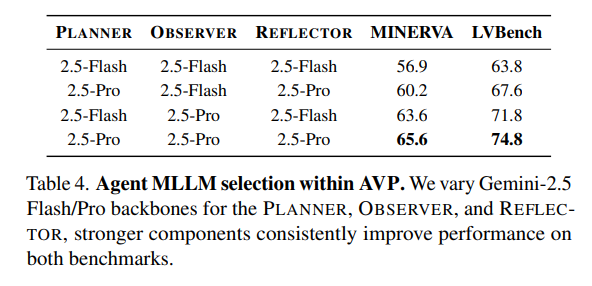

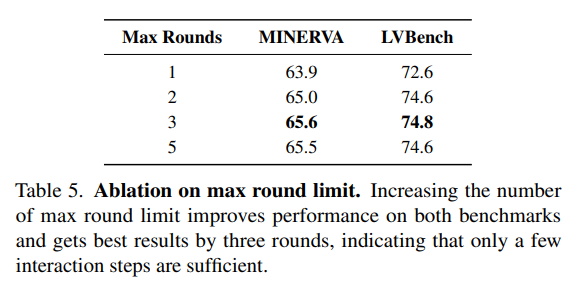

Table 3~5는 ablation 실험입니다. table3는 저자가 제안하는 방법론의 각 단계가 얼마나 효과가 있는지를 보여주고 있고, table4는 MLLM을 어떤 모델을 사용했을 때가 성능이 제일 좋은지를 보여줍니다. 당연히(?) Pro모델만을 사용할 때가 가장 성능이 좋은 것을 확인할 수 있습니다. 마지막으로 table5는 회차 반복의 최대치를 어떻게 하는게 최적일지를 보여주는 표입니다. 저자는 3이 최적이며 그보다 커지면 오히려 커지는 입력 컨텍스트로 인해 비효율적이며 성능도 큰 차이가 없음을 보여줍니다.

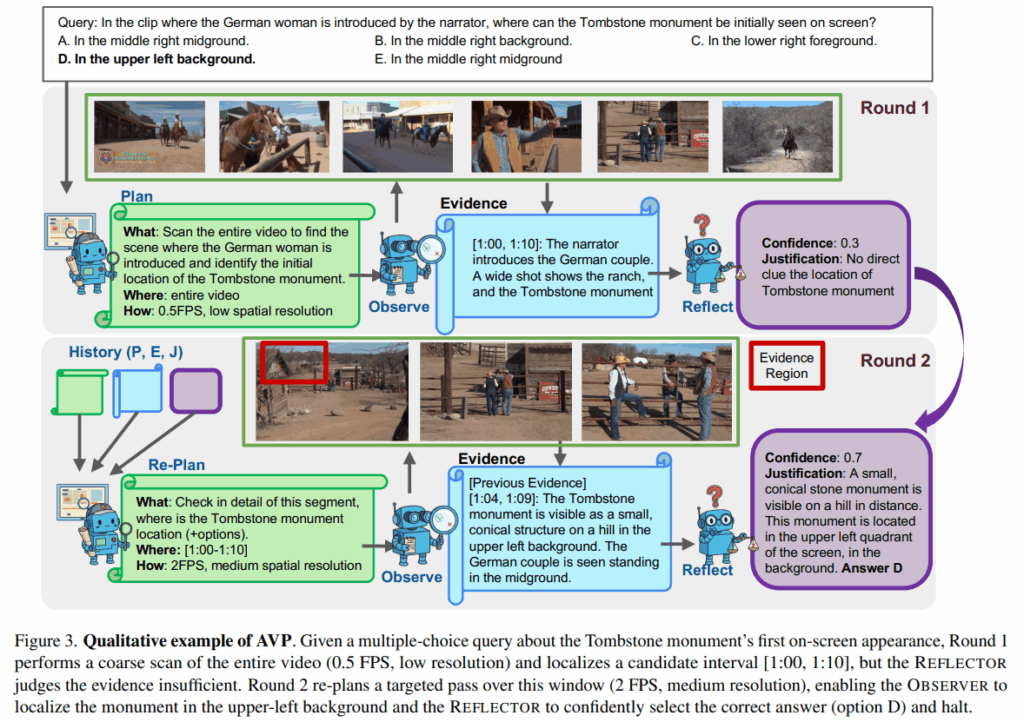

Figure3는 AVP의 정성적인 결과입니다. 감사합니다.