연구주제를 찾아해메고있는 한대찬 연구원입니다.

숙명과도 같은 Thermal Depth estimation 관련 논문을 서베이 하던 도중 못보던 논문이 등장해서 가져와봤습니다. 아직은 arxiv 이지만 포맷과 저자의 논문 기록들을 봤을 때 아마도 ICRA나 IROS에 제출한게 아닐까… 혹은 RAL에 제출하지 않았었을까 생각중입니다.

어디에 제출한건지 찾아보다가 대학교 이름을 보니 Nanjing 대학교네요. 뭔가 익숙하다 했더니 얼마전에 저희에게 데이터 셋을 요구했던 …. 그렇지만 전부를 주지는 못했던 친구였네요…. 허허 github 보니까 6개월전에 만들었던데 아직까지 public 안된거 보면 IROS 제출했다가 비교군이 적어서 떨어졌고 그래서 저희한테 데이터 셋을 요청해서 ICRA 제출을 목표로 하고 있는게 아닐까… 생각중입니다. 그치만 데이터 셋 전부를 받지 못해서 굉장히 슬퍼하고 있지 않을까 싶습니다. 살짝 … 아니 많이… 미안해지네요.

먼저 이 논문에서 기존 thermal -RGB depth estimation 에는 크게 세가지 문제가 있다고 합니다.

- domain 이 달라서 학습이 되지 않는다.

- 기존 방법론들은 서로 다른 spectrum 끼리 정보를 공유함. ( 이게 문제라면서 translation 했을때 texture 가 다르다는걸로 증명하는데, 이 논문도 동일하게 하고 있으면서… 왜 문제라고 하는지 모르겠음)

- 데이터 셋이 부족함

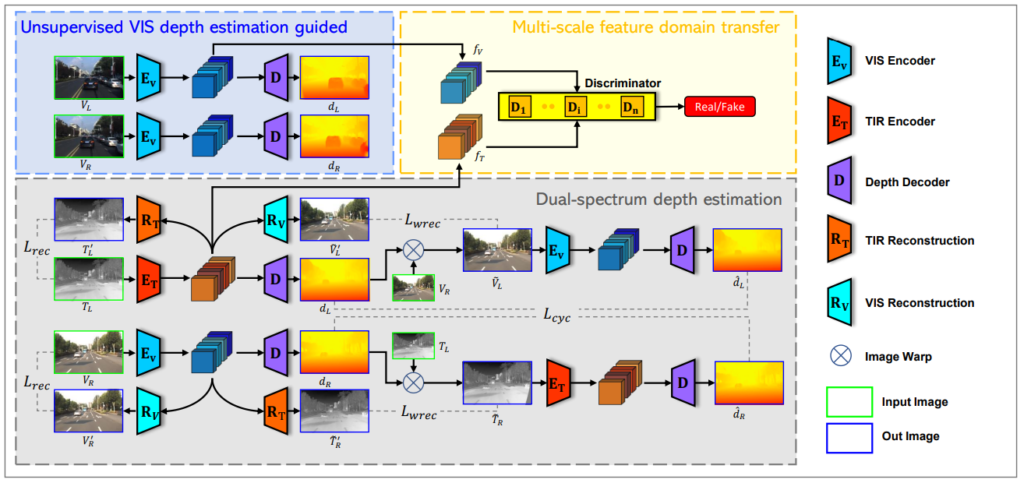

암튼 이와 같은 문제를 해결하고자 아래와 같은 시스템을 설계했다고 합니다.

제안하는 방법론은 총 세가지 스탭을 밟는데 그 순서는 다음과 같습니다. 세가지 파트라 해서 3 stage라 생각했지만 저 모든것을 한번에 학습시키는 것 같습니다. 그리고 음… 1번 과정 또한 Thermal 가지고도 합니다.

- RGB 를 이용해서 Self-supervised depth model을 학습시킴

- RGB와 Thermal feature 가 유사해지도록 discriminator를 태워서 학습시킴

- 마지막으로 Dual-spectrum depth estimation 학습을 통해서 thermal depth estimation 성능을 향상 시킴

위에 순서대로 간단히 다시 설명드리도록 하겠습니다.

먼저 RGB 이미지 left -right 를 이용해서 먼저 depth estimation 모델부터 학습시킵니다. 학습 방식은 Monodepth 1 과 동일합니다. left-right consistency loss 와 smoothing loss를 이용해서 학습시킵니다. 이를 통해서 Depth decoder 와 RGB를 입력으로 받는 Encoder를 학습시켜줍니다.

다음으로 RGB의 encoder feature 를 이용해서 thermal encoder를 학습 시키는 것입니다. ( 사실 음… 결국 Thermal 도 recontruction loss 도 써서 RGB 성능을 transfer 한다기 보다 MDII 처럼 RGB와 Thermal 의 feature가 유사한 공간으로 옮긴다? 정도로 이해하면 될 것 같습니다. )

Discriminator를 이용해서 RGB 와 Thermal encoder feature 가 유사해지도록 하며 추가적으로 위 그림 속 RT와 RV와 같은 Image Generator에 각 feature를 넣어서 어떠한 feature 가 들어오더라도 두 영상을 제대로 generation 할 수 있도록 합니다. 이를 통해 두 feature를 더욱 유사하도록 학습 시킵니다.

마지막으로 각 영상을 입력으로 생성된 Disparity 로 warping시킨 두 도메인의 이미지를 이용해 disparity를 예측한 후 Lcyc를 계산합니다. 이때 모든 feature롸 Lcyc는 L1 distance 를 이용해 계산했습니다.

Results

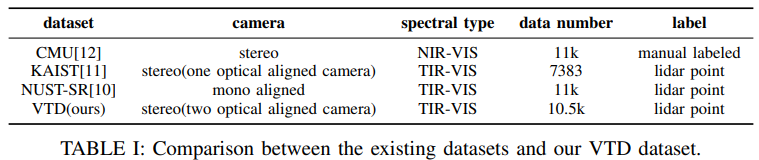

이 논문에서는 데이터 셋도 제안합니다. 위 와 같이 VTD라는 데이터셋을 제안하는데요 이건 RGB와 Thermal를 모두 Stereo로 구성된 데이터 셋을 제안하며 이 데이터셋은 RGB와 Thermal가 빔스플릿터를 이용해서 align 이 맞는다고 합니다.

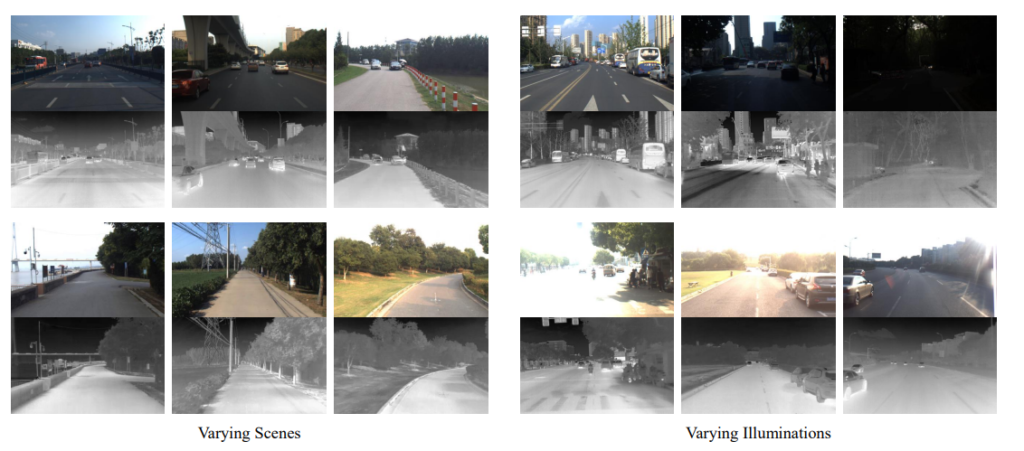

그리고 당연하게도 조도변화에 강인한 것을 측정하게 위해서 다양한 조도 환경을 촬영해서 포함합니다.

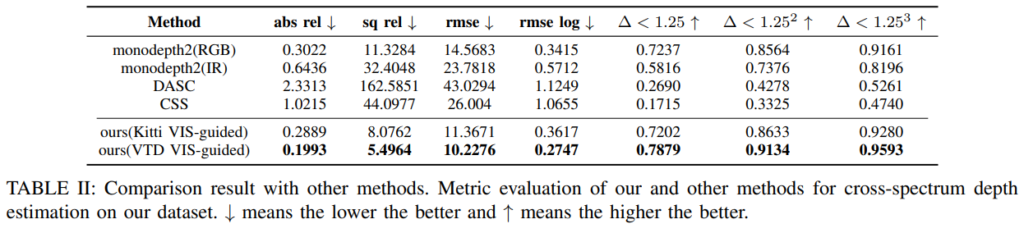

제안된 데이터 셋에서 성능 평가입니다. 단순히 학습 시킨 것 보다 Ours 가 성능이 훨씬 좋은 것을 볼 수 있습니다. 이게 음… 비교 방법론들이 조도변화가 강해서 이렇게 성능이 안나오는 건지.. IR 성능이 너무 안나와서 의아합니다. 그리고 조도 변화가 강하다고 하면 오히려 RGB 보다 IR이 성능이 잘나와야할 것 같은데…흠흠 Ours 도 input을 IR과 RGB 나눠서 측정했더라면 좋았을텐데 …

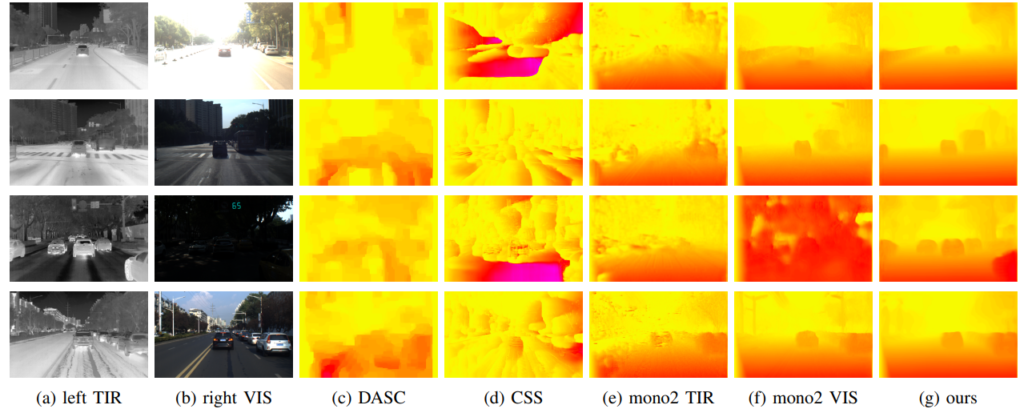

정성적으로 봤을때 위에서 의아했던 부분이 어느 정도 해소가 됩니다. 낮에는 Mono2 TIR이 성능이 안좋지만 밤에 VIS의 성능이 망가지는 것을 볼 수 있습니다. 그렇지만… 음 밤에 이렇게 망가지면 평균이 진짜 더 안좋게 나올 것 같은데 밤데이터가 test에 적은가 봅니다.

Ours가 어떠한 조도 상황에도 좋은 성능이 보이는 것을 볼 수 있습니다.

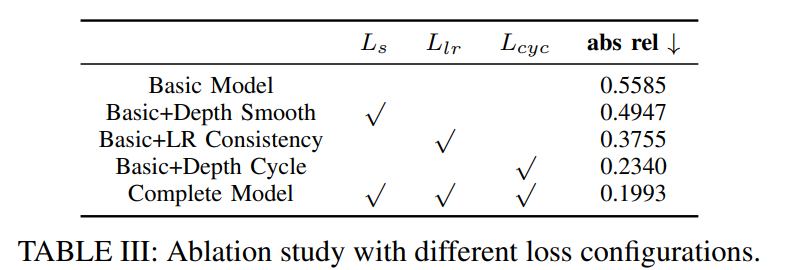

ablation study 입니다. thermal model에 하나씩 붙혀가며 성능을 측정한 것 입니다. Depth Cycle 의 성능 향상이 매우 뛰어 난 것을 볼 수 잇습니다.

데이터 셋을 못준 것을 미안하지만.. 이대로 ICRA를 냈다면 … 떨어지지 않을까 .. 싶습니다. 그래도 이논문에서 제안한 데이터 셋을 받고 싶은데 논문이 public 된다면 공개한다고 합니다. 따라서 어서 ICRA 붙기를 기원 해봅니다.

리뷰 잘 봤습니다.

기존의 KD 방식 말고 다른쪽을 서베이하고 계시는군요,,

최종적으로 졸업논문을 작성하고자 하는것이 Thermal Depth Estimation 인가요??

thermal와 RGB의 encoder feature가 유사해지도록 학습한다 하셨는데 그렇다면 f_r을 R_v에 적용할 경우 rgb영상과 유사한 right 이미지가 만들어지지는 않을 지 궁금하네요.. 이에 대해 대찬님은 어떻게 생각하시나요??