Code : link

Presentation : link

Paper : link

Dataset : link

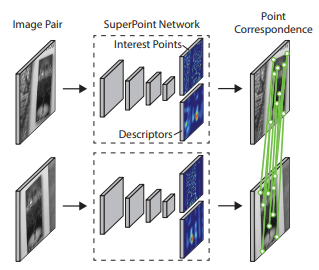

해당 논문은 제가 현재 진행하고 있는 Multipsectral Registration 연구 입니다. 해당 연구는 Super point의 방법을 Multispectral 분야에 적용하고 있습니다. 여기서 Super point는 네이버랩스 챌린지에서 많은 연구원 분들이 사용하셨기 때문에 알고있을 것이라 가정하고 간단하게만 설명하자면, 두 영상에서의 Correspondaence point를 얻기위해 Interest point와 해당 포인트의 descriptors를 딥러닝을 이용하여 추출하는 방법입니다. 고전방법으로는 SIFT, SURF 등이 있습니다.

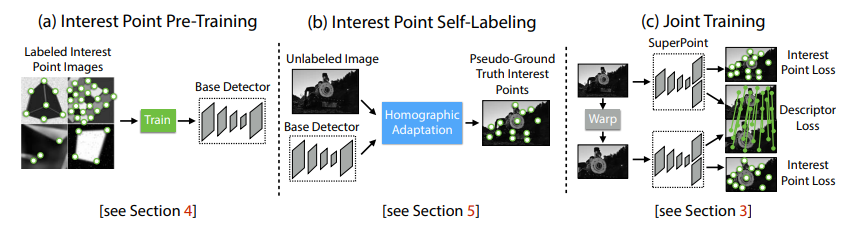

해당 논문에서는 이러한 Super point의 컨셉을 Multispectral에 적용하여 Multi point 라는 방법을 제안합니다. Multipoint는 cross-spectral의 interest point를 감지(detection)하고 기술(description)하는데 이를 학습하기 위해 논문에서 소개하는 방법은 다음과 같습니다.

Stage 1 : Interest point label generation

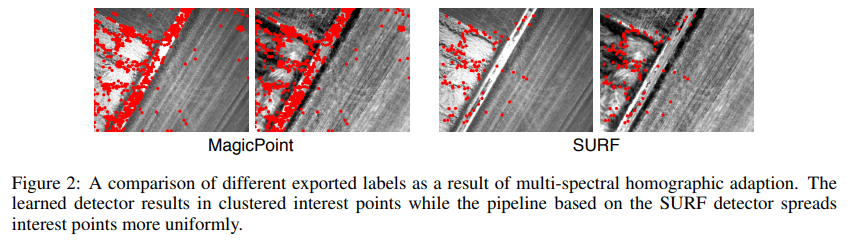

Superpoint에서는 synthetic 3D scene에서의 cuboids, checkerboards, line segments등을 2D로 project하고 이를 통해 얻어진 ground truth target을 가지고 interest point detector를 학습했다고 합니다. 하지만 해당 논문에서 저자는 이러한 방법은 multi-sepctral data에서는 잘 prepresent 하지 못하기 때문에 non-data-driven 방식의 SURF (혹은 SIFT)를 interset point detector로 사용하여 cross spectral의 interest point를 구했다고 합니다. 이때 딥러닝 방식으로 학습한 detector는 heatmap 형식으로 interest point가 구해지지만 SURF (혹은 SIFT)는 individual candidate interest point를 얻기 때문에 이를 Super point에 적용하고자 Gaussian filter를 이용해 smooth하게 하여 heatmap을 만들었다고 합니다.

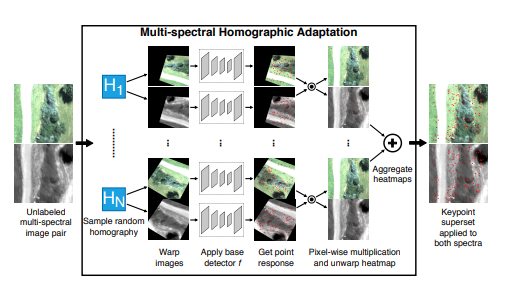

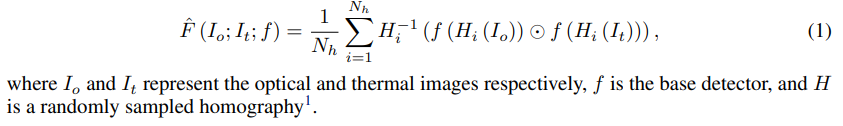

Stage 2 : Multi-spectral homographic adaptation

먼저 멀티스펙트럴 이미지 페어가 있으면 먼저 sample random homography를 이용하여 각 이미지를 Homography 변환을 시킵니다. 그리고 이렇게 변환된 이미지에서 앞서 설명한것처럼 SURF(혹은 SIFT)를 이용하여 interest point를 추출한 이후 가우신안 필터를 이용하여 heatmap을 얻습니다. 그리고 구하진 heatmap 끼리 곱해서 하나의 heatmap을 만들고 이를 다시 Homography로 인버스해서 최종적인 페어 이미지의 interest point를 구한다고 합니다. 이를 수식으로 나타내면 아래와 같습니다.

이렇게 interest point를 구하여 시각화하면 아래와 같다고 합니다.

Stage 3: Joint detector and descriptor training

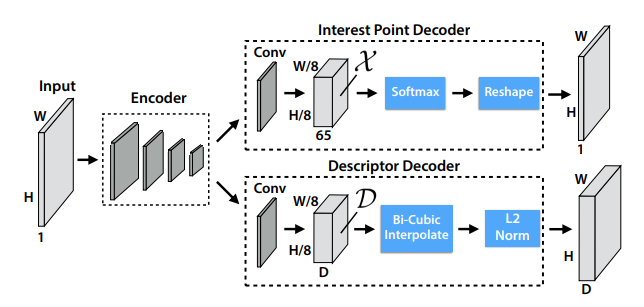

마지막은 이제 DNN을 만들고, 학습하는 방법 입니다. 앞선 과정에서 두 멀티스펙트럴 이미지 페어의 paired interest point는 구했으므로 이를 GT로 모델을 학습합니다. 모델 아키텍처는 해당 논문에 없어 Super point의 그림을 가져와서 확인하면 아래와 같습니다.

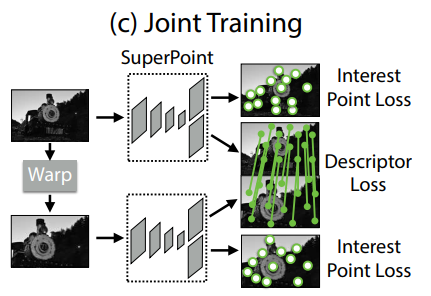

이러한 모델을 이용하여서 Super point에서 사용한 방법과 동일하게 학습을 수행합니다.

위의 그림과 같이 실제 paired interest point GT가 있으므로 이를 이용하여 학습합니다. 추가로 해당 논문에서는 50%는 multispectral pair, 나머지 50%는 samespectral pair(visible-visible, thermal-thermal)를 이용하여 학습했다고 합니다.

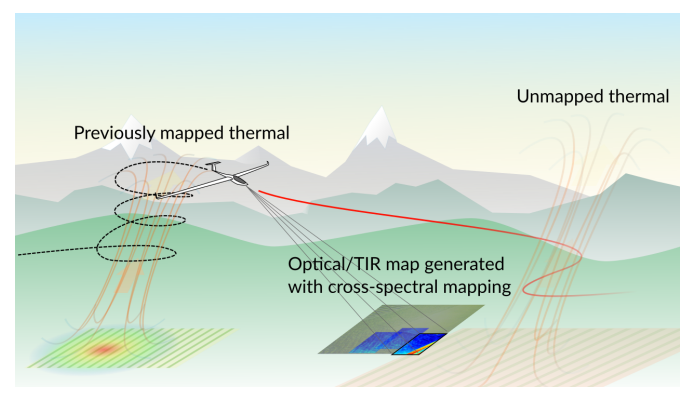

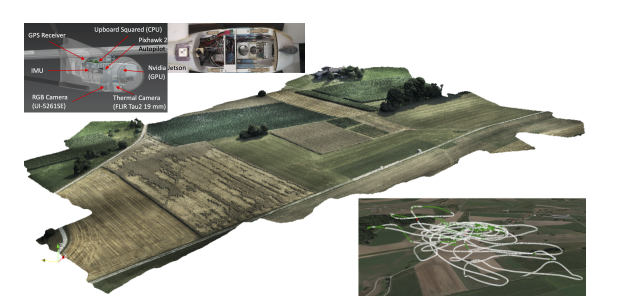

해당 논문에서는 이러한 자신들의 방법론을 학습 및 평가하기 위한 데이터셋도 함께 공개하고 있습니다. 그리고 논문에서 이러한 데이터셋 구축을 위한 내용도 함께 기술합니다. 해당 논문은 위의 그림과 같이 공중에서 촬영된 멀티스펙트럴 이미지를 사용합니다. 자세한 데이터셋 내용들은 논문을 참조하시면 되고, 제가 생각할때 필요한 부분들을 설명하도록 하겠습니다.

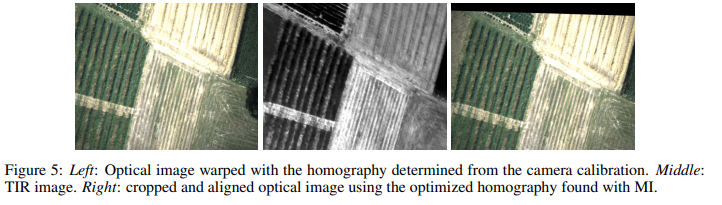

Offline multi-spectral feature matching

앞서 설명한 모델의 학습 및 interest point 추출을 위해서는 얼라인이 잘 맞는 멀티스펙트럴 이미지 페어가 필요합니다. 따라서 본 연구에서는 이 과정을 오프라인으로 진행하였다고 합니다. 이미지 페어를 맞추기 위해서 저자는 MI score cost function을 이용하여 두 영상의 relative homography를 풀어서 최적화 하였다고 합니다. 그리고 이를 위한 solver로는 Nelder-Mead solver를 사용했다고 합니다. 마지막으로 그래도 잘못 매칭이 이뤄졌으면 hand-tune으로 진행했다고 합니다.

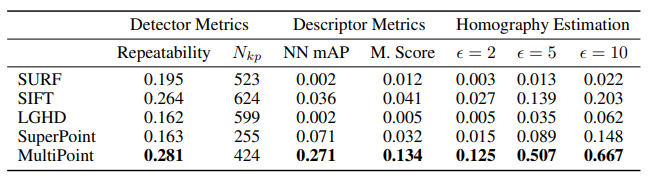

Experiment

자신들의 방법이 당연히 성능이 좋았다고 나타내고 있습니다. 성능 지표는 논문을 참조바랍니다.

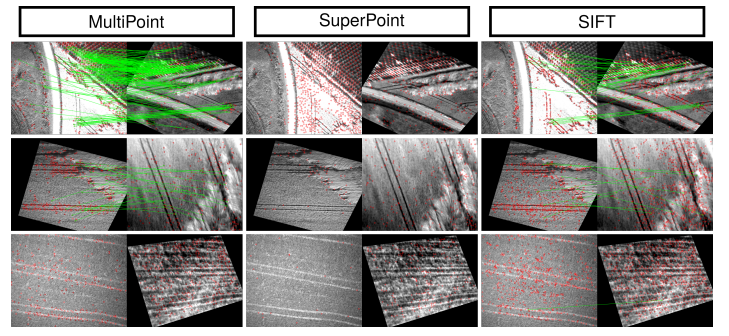

정성적 결과를 나타냈는데…(저는 잘모르겠습니다..)

Conclusion

해당 논문에서 공개한 데이터셋을 이용하여 현재 제가 진행하는 Unsupervised 방식을 이용하여 평가해서 비교하면 좋은 비교대상이 될 것 같습니다.

“MI score cost function을 이용하여 두 영상의 relative homography를 풀어서 최적화 하였다”이부분을 좀더 자세히 설명해 주실 수 있을까요?

저도 궁금했는데 해당 논문에 나타난 내용은 아래가 전부입니다.

“To calculate the ‘ground-truth’ homography between multi-spectral image pairs, we developed a pipeline based on the MI score”

“we used an optimizer to solve for the relative homography between images using the MI score

as the cost function [22]”

[22]번에 논문을 참조하였는데, 22번의 논문은 “Alignment by maximization of mutual information” 라는 논문에서 제안된 방법 같습니다. 해당 논문을 참조하시면 될 것 같습니다.

오프라인으로 진행했다는것이 어떤 의미인가요. Hand tune을 했다는건 결국 사람이 개입했다는 의미아닌가요?

본문에서 언급한것처럼 모델 학습을 위해서는 얼라인이 잘맞는 멀티스펙트럴 이미지 페어가 필요합니다. 따라서 이를 위한 데이터셋을 오프라인으로 만들었습니다. 즉 사람이 개입하여 학습및평가 데이터셋을 만들었음을 의미합니다. 이부분에 문제될 부분은 없습니다.