해당 논문은 ‘Heng ZHANG‘이라고 Multispectral Pedestrian Detection을 열심히 수행하는 한 연구자가 작성한 논문입니다. 해당 저자는 이 논문을 제외하고도 성능이 높은 네트워크들을 제안했었습니다.

다시 본론으로 돌아와서 2021 ICIP에 제가 생각했던 문제를 해결한 해당 논문을 발표하여서 가져왔습니다. 제가 설명하기에 앞서 저자가 직접 유튜브에 링크한 발표영상도 아래에서 확인하실 수 있습니다.

INTRODUCTION

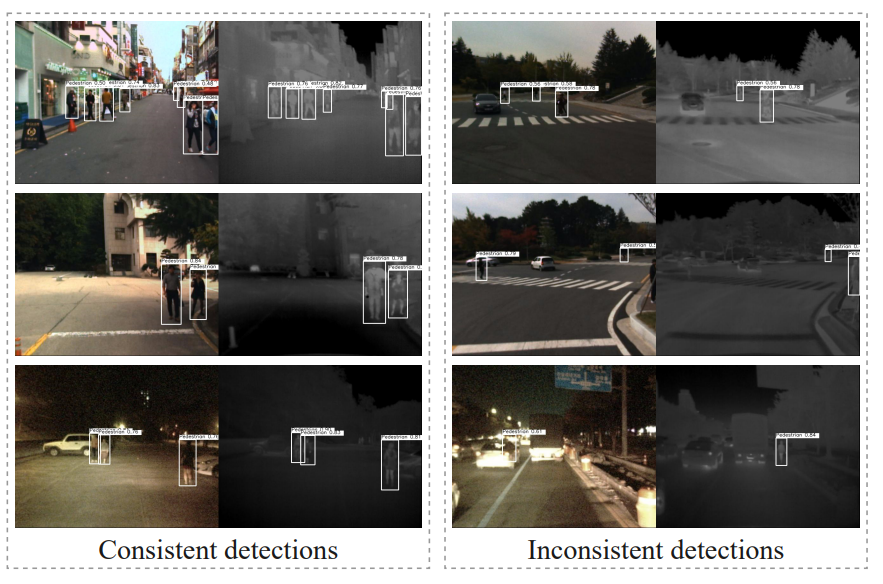

위의 그림은 단일 모달리티에서 학습한 detection 결과를 나타낸 그림입니다. 두 멀티스펙트럴 이미지의 detection 결과가 일치하는 ‘Consistent detections’가 있는 반면, 두 결과가 일치하지 않는 ‘Inconsistent detections’가 있습니다. 이러한 결과로 알 수 있는 사실은 두 모달리티가 ‘redundancy(중복)’하면서 동시에 ‘complementarity(상호보완적)’ 이기도 한 것을 의미합니다.

멀티스펙트럴 연구에서 이러한 두 특성을 모두 학습할 수 있다면 좋지 않을까요? 하지만 이러한 것들을 모두 하나하나 라벨링 하기에는 너무 많은 비용이 들어갑니다. 그래서 저희 MLPD 논문에서는 이러한 문제를 augmentation으로 해결하려고 하였습니다. 해당 논문의 저자는 이러한 두 특성을 모두 고르게 모델이 학습하여 좋은 성능을 내는 동시에 라벨링에 들어가는 시간과 자원을 절약하기 위해 cross-modality prediction inconsistency 기반의 active criterion을 제안합니다.

APPROACH

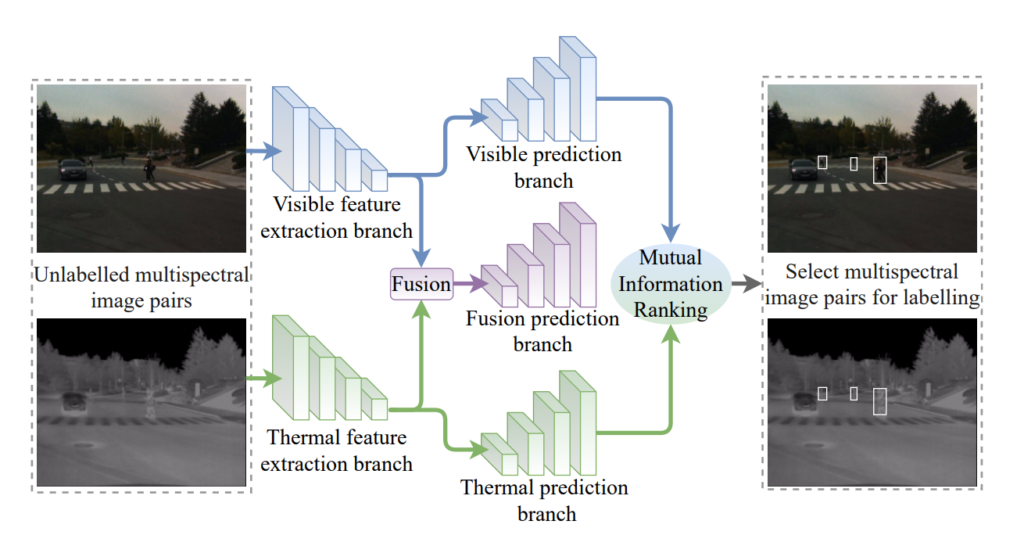

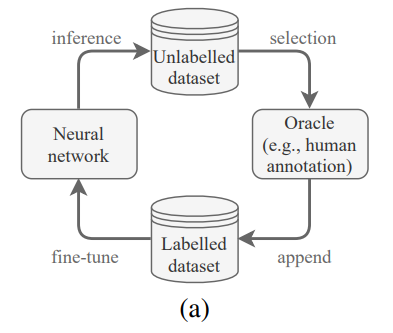

본 논문에서 사용되는 전체 아키텍처 입니다. 3가지 브랜치를 가지고 있으며, RGB와 Thermal 따로 예측하는 브랜치와 RGB-Thermal을 융합한 브랜치 입니다. 여기서 RGB와 Thermal을 따로 예측하는 브랜치의 결과를 통해서 Fusion 브랜치를 학습할 레이블을 선택하게 됩니다. 그리고 이러한 방법을 저자는 Active learning loop diagram과 유사하다고 이야기합니다.

Cross-modality prediction inconsistency

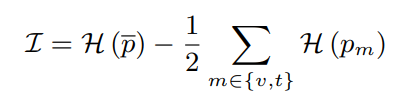

그럼 inconsistency와 consistency는 어떻게 active하게 선정할 수 있을까요? 이를위해 저자는 inconsistency를 다음과 같이 정의합니다.

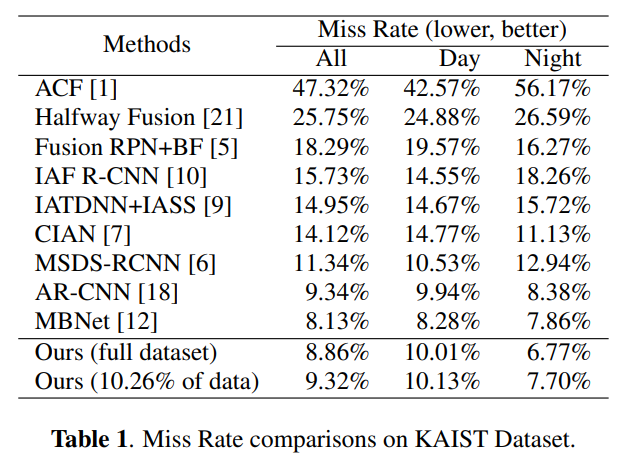

위의 수식에서 p는 각 prediction을 의미하며, v는 visible t는 thermal 을 의미합니다. 또 p바는 두 모달리티 prediction의 평균을 의미합니다. 또 H는 binary(2-set) entropy function을 의미하며 수식은 아래와 같습니다.

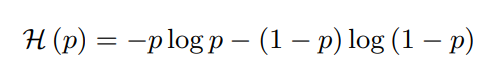

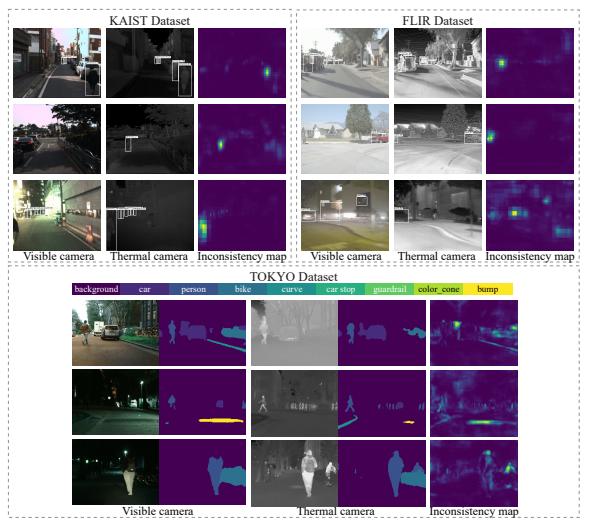

정리하면 두 모달리티 예측의 평균에 대한 ‘2-set entropy function’ 계산값에서 각 모달리티에 대해서 ‘binary(2-set) entropy function’을 계산한 것의 평균을 빼준 것을 inconsistency로 수식화하게 됩니다. 그리고 이해를 돕기위해서 저자는 이를 아래와 같이 시각화하여 나타냅니다.

EXPERIMENTS

자신의 방법이 멀티스펙트럴 분야에서 효과적임을 보이기 위해서 KAIST, FLIR, TOKYO 데이터셋에 대해서 검증하고, Detection 뿐만 아니라 Segmentation에 대해서도 실험적으로 나타내고 있습니다.

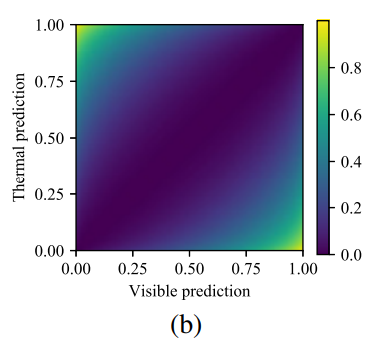

- KAIST Dataset

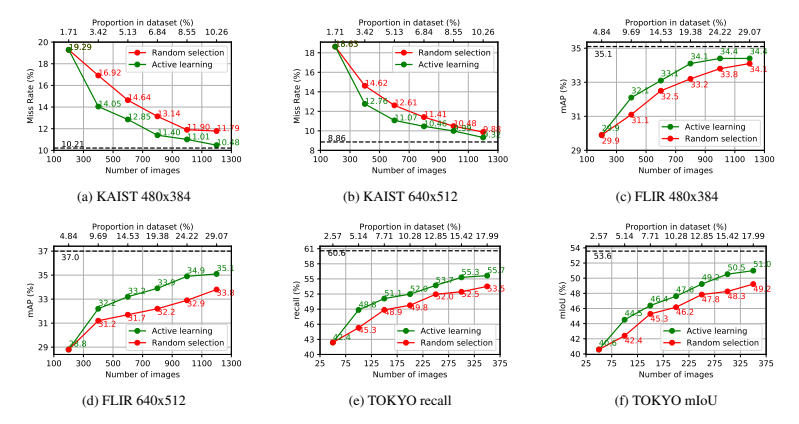

KAIST 데이터셋 평가결과에서 특징적인 부분은 전체 데이터셋을 사용하지 않아도 준수한 성능을 보인다는 점 입니다.

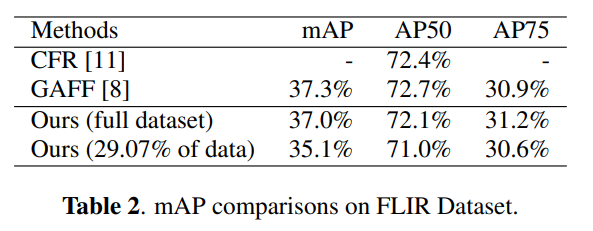

- FLIR Dataset

FLIR 셋에서 Misalignment가 크게 존재하는데, 해당 데이터셋에 대해서도 유의미한 성능을 나타내고 있습니다. (CFR과 GAFF는 모두 이 논문의 저자가 이전에 제안한 모델이며, 성능도 MLPD보다 우수합니다.)

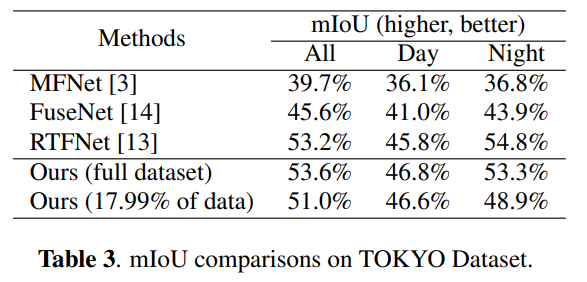

- TOKYO Dataset

또한 Segmentation에 대해서도 효과가 있음을 나타냅니다. (MLPD 작성시 저도 RTFNet에 multi-label을 적용하여 확인하려고 하다가 잘 안됐는데 대단하네요..)

- Actvie VS Random

또한 이뿐만 아니라 자신들의 방법이 Active learning에서 착안한것에 대한 성능을 나타내기 위해서 랜덤으로 선택하는 방법과 비교하기도 합니다.

Visualization

결론

해당 논문은 2021 ICIP에 제출된 논문이며, 금일 논문을 확인했지만 발표자료는 유튜브 기준으로 7월 20일, 논문은 IEEE Xplore에 8월에 공개됐습니다. 해당 논문의 컨셉이 MLPD와 굉장히 유사하고 저희가 하려고했던 실험들을 해당 논문에서는 보이고 있어서 놀랐습니다. 논문작성 당시 저희의 메일을 무시해서 별로 좋게 안봤는데 후속 논문들과 연구를 보니 계속 지켜봐야할 전문가인것 같습니다.

해당 저자의 홈페이지를 확이나니 WACV 2022에 새로운 논문을 낸것으로 파악되는데, 해당 논문에 대해서도 공개된다면 바로 확인해봐야할 것 같습니다.