Self-supervised depth estimation은 현재 KITTI나 NYU와 같은 벤치마크에서 높은 성능을 보이며 곧 있으면 Supervised 방법론과도 비교를 할 수 있는 순간까지 왔습니다. 하지만 이 모든 연구의 방향성은 RGB 카메라(visible camera)를 전제로 하고 있습니다. 이 RGB 카메라는 빛의 정보를 가진 센서로 밤시간대와 같은 low – light condition에서는 사용자가 혹은 인공지능 모델이 원하는 정보를 주지 못합니다. 따라서 그에 대한 해결책으로 thermal 카메라가 보행자 인식이나 semantic segmentation, stereo self-supervised depth estimation과 같은 분야에서 최근 제안되고 있습니다. 하지만 thermal 카메라에서 얻을 수 있는 이미지는 RGB 이미지와 달리 노이즈가 있고 엣지가 불명확하며 물체의 온도 분포가 일정하지 않다는 이유로 정통적인 self-supervised depth estimation 에서의 사용이 어려웠습니다. 이 논문에서는 이러한 RGB와 Thermal의 차이를 줄여줄 수 있는 학습 loss와 파이프라인을 제안하여 밤낮에서도 강인한 Depth estimation 방법론의 성능을 보여줍니다.

- Method

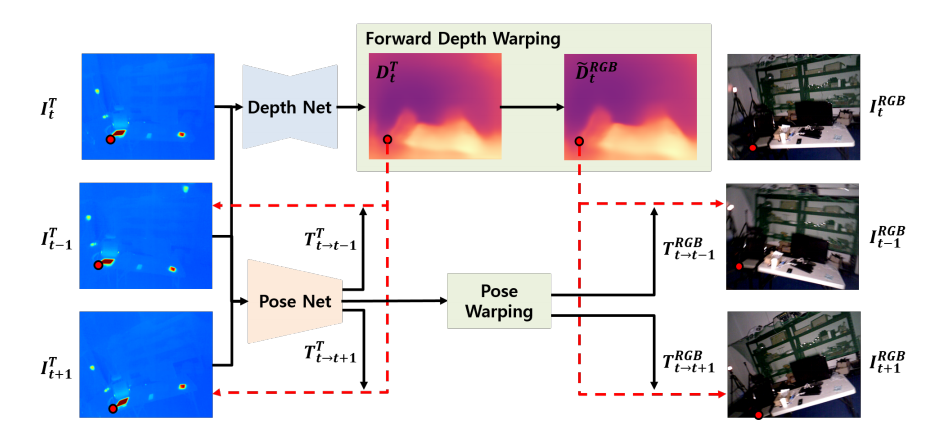

전체 파이프라인은 위 그림과 같다. Thermal 로 부터 Depth map을 생성한 후 이를 이용해 Thermal 를 Recontruction하고 RGB 또한 Recontruction합니다. 그 후 Recontruction 된 이미지들을 이용해 loss 계산을 하여 학습을 합니다. 이때 Thermal와 RGB의 차이를 보정하기 위한 Forward Depth warping module을 제안하며 이를 통해서 Thermal에서 추출한 Depth를 RGB의 Depth로 활용이 가능해지며 RGB의 정보를 학습할때 사용할 수 있게됩니다.

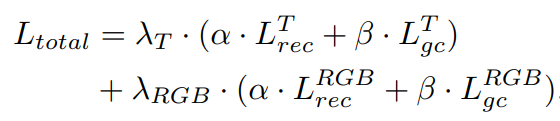

학습을 위한 Total Loss는 다음과 같다. Lrec는 각 도메인이 Recontruction 된 것을 가지고 Loss를 구사는 것이고 Lgc는 e뒤에서 설명하겠습니다. 위 식과 같이 Thermal 와 RGB 의 재복원 영상을 이용해 학습을 합니다.

Temperature Consistency Loss

Thermal 의 Reconstruction loss는 기존 RGB Self -supervised 에서와 동일합니다. 영상간의 시차가 발생하면 온도가 달라 질 수 있지만 이 파이프라인에서 가정하는 T시간과 T+1시간대 정도의 시간 차이에서는 동일한 물체는 동일한 온도를 낼 것이라고 합니다.

식을 보면 기존 방법론과 같이 SSIM과 L1을 이용해서 Recontruction thermal와 target thermal을 비교하여 Depth Network를 학습합니다.

Photometric Consistency Loss

Thermal 영상을 Recontruction Loss만을 이용해 학습할 경우 위에서 언급한 Thermal의 문제점으로 인해서 성능의 한계점이 존재합니다. 이를 막기 위해서 그림1과 같이 RGB 영상을 학습할때 사용하며 위 과정을 통해서 RGB의 장점을 Depth Network가 학습할 수 있도록 합니다.

RGB 정보를 Depth Network에 전달하기 위해서 이 논문에서는 생성된 Depth Map과 Pose를 이용해서 target thermal와 pair를 이루는 target RGB를 Source RGB로 Recontruction 합니다. 이때 구한 Pose와 Depth는 Thermal 카메라 기준이기 때문에 RGB 카메라과 Thermal 카메라가 촬영된 Pose가 달라서 기존의 추가적인 모듈이 필요합니다.

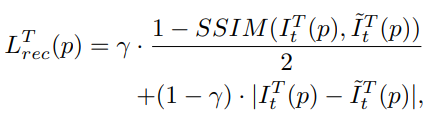

이 논문에서는 Thermal 에서 예측된 Depth Map을 RGB 카메라 기준으로 바꾸기 위해 위와 같은 모듈을 제안합니다. 실제 Target Thermal와 Target RGB 사이의 RT 관계를 이용해서 T에서 RGB로 변환 Matrix를 구한후 [1] 에서 제안된 Flow 역변환 network를 이용해 RGB 2 Thermal 변환 Matrix(Backward Rigid Flow) 를 구해줍니다. 구해준 Backward Rigid Flow와 Thermal 에서 예측된 Depth Map을 이용해 RGB의 Depth Map을 생성합니다. 이렇게 구한 RGB Depth Map을 이용해 RGB 영상도 Recontruction을 하고 [Eq 1] 을 이용해 Synthesized RGB와 Source image를 비교해서 Loss를 구합니다.

Geometric Consistency Loss

이 논문에서는 [2] 에서 스케일에 강인한 Depth 추정을 위해서 제안된 geometric consistency loss 를 사용하였으며, 씬이 바뀌어도 Thermal 의 균일한 온도를 가지는 특징과 이 로스와 결합하여 Smoothness 효과도 가져왔다는 것을 찾았다고 합니다.

2. Result

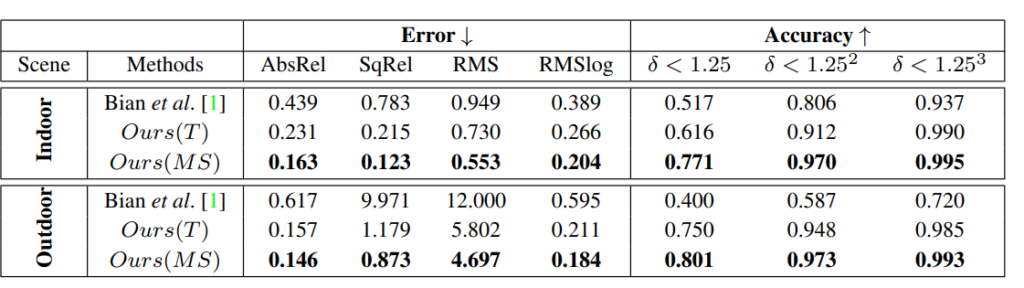

ViViD Dataset에서 Depth estimation 결과 입니다. Our(T)는 Thermal 만 학습에 사용한 것이고 Our(MS)는 Multispectral을 사용한 것입니다. 보면 확실히 RGB 정보가 학습에 사용된 Our(MS)가 좋은 성능을 보이는 것을 알 수 있습니다.

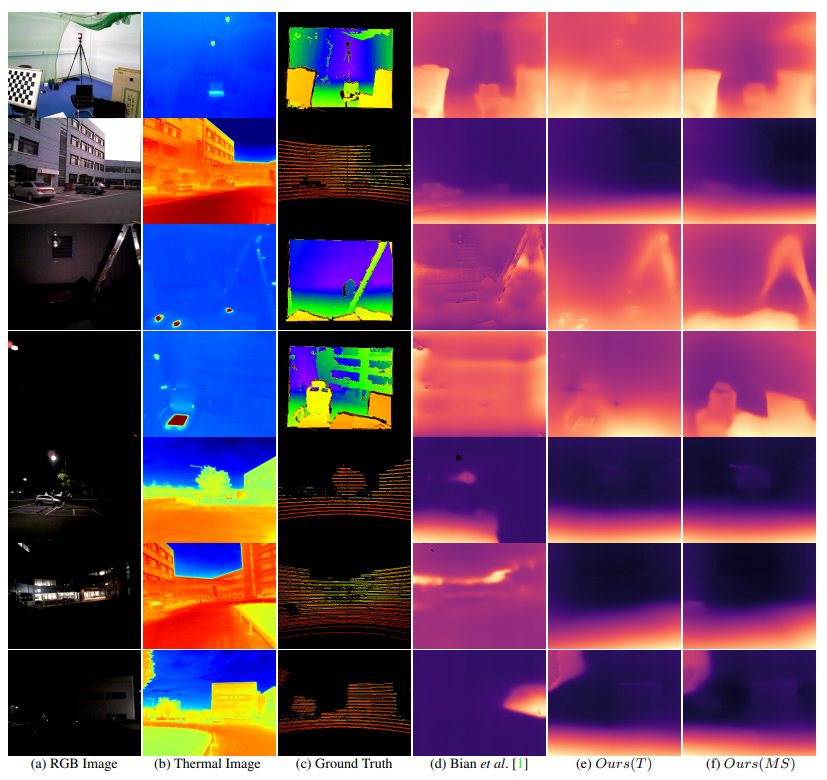

정성적으로 보았을때 비록 낮 상황에서는 RGB 보다 못한 결과를 보여주지만, 밤 상황에 대해서는 더 나은 결과를 보입니다.

———————————

[1] Xu, Xiangyu, et al. “Quadratic video interpolation.” arXiv preprint arXiv:1911.00627 (2019).

[2] Bian, Jiawang, et al. “Unsupervised scale-consistent depth and ego-motion learning from monocular video.” Advances in neural information processing systems 32 (2019): 35-45.