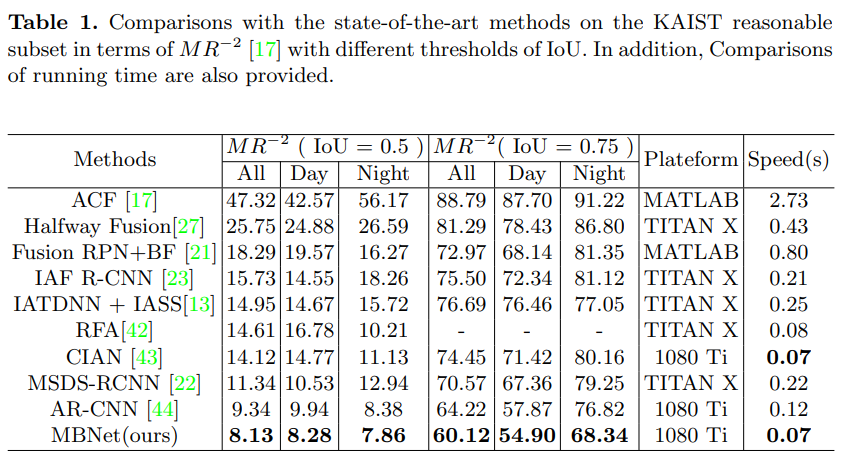

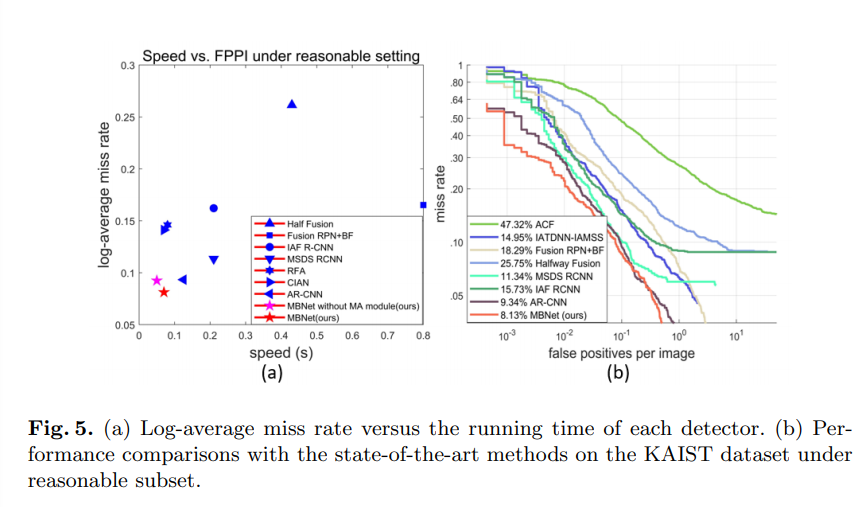

이번 리뷰 논문은 Multispectral Pedestrian Detection 분야 중 RGB-Thermal camera를 이용한 1-stage 분야의 SOTA를 달성하고 있는 Modality Balance Network(MBNet)을 소개하고자 합니다.

해당 논문의 주 기여는 modality간의 불균형 문제를 정의하고, 불균형 문제를 해결함으로써 SOTA를 달성한 것에 있습니다.

Intro

물체 인식에서는 대표적으로 클래스에 대한 불균형과 전경-배경의 불균형 문제들이 성능에 영향을 주며, 전통적인 기법들은 이들의 관계를 계수로 계산하여 해결하고자 노력했습니다.

해당 논문에서는 클래스와 전경-배경의 불균형 뿐만 아니라, modality의 불균형 또한 성능에 큰 영향을 준다고 이야기 합니다.

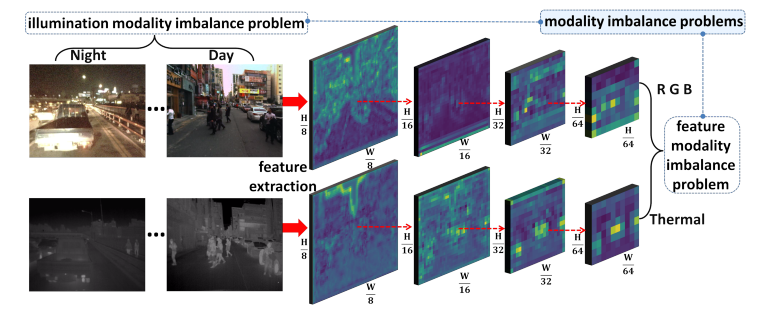

해당 논문에서 정의하는 modality의 불균형은 Fig 1과 같이 두 가지로 나누어 봅니다.

- Illumination modality imbalance

- Feature modality imbalance

먼저 illumination modality imbalance의 의미는 낮과 밤에서의 modality의 차이입니다. Fig 1과 같이 낮 시간의 RGB에서는 Thermal보다 보행자의 구분이 명확합니다. 하지만 밤 시간에는 오히려 Thermal가 보다 명확하게 구분을 하게 됩니다. 이로인해 RGB/Thermal (modality)의 illumination로 인한 불균형 생깁니다. 그렇기 때문에 illumination conditions에 따라 modality 간 score를 조절해야하는 필요성이 생깁니다.

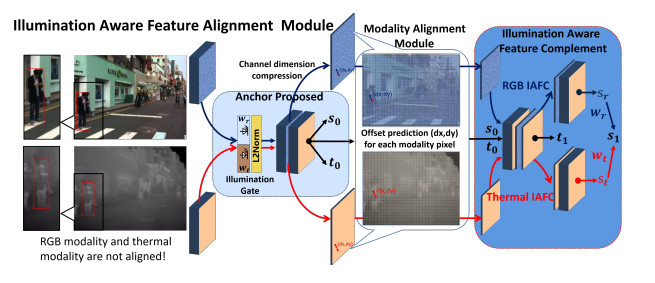

다음으로는 Feature modality imbalance의 의미는 modality 장비들의 미정렬과 부적절한 통합으로 인해 불균형한 feature 표현을 가지는 문제입니다. 해당 문제는 주로 두 독립된 backbone network로 부터 얻어 지게 됩니다. RGB인 경우는 보행자의 헤어 스타일과 얼굴 유곽이 주요한 feature의 특성으로 작용됩니다. 하지만 Thermal에서는 발견하기 힘듭니다. 하지만 이 특성은 강인한 feature 표현을 위해서는 필요한 부분입니다. 또다른 부분은 RGB/Thermal 간의 미정렬로 고정된 크기의 convolution kernel에 들어감으로써 생기는 부분입니다.

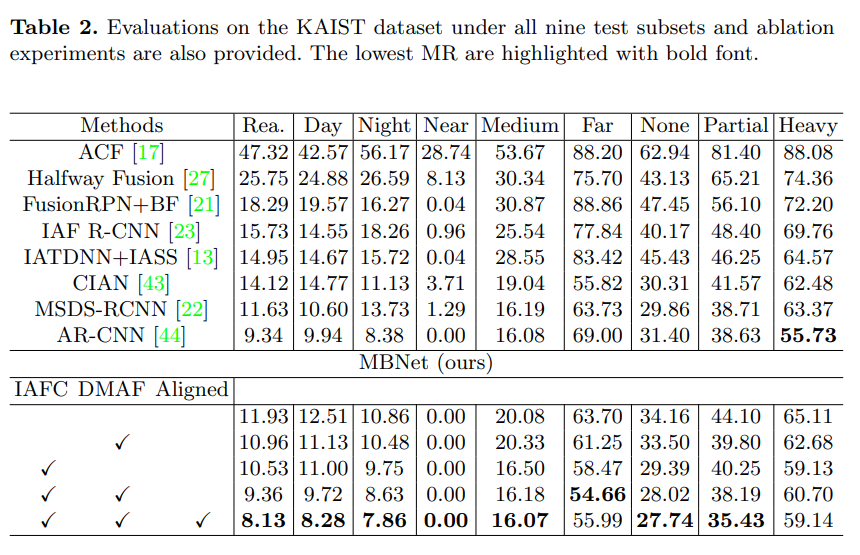

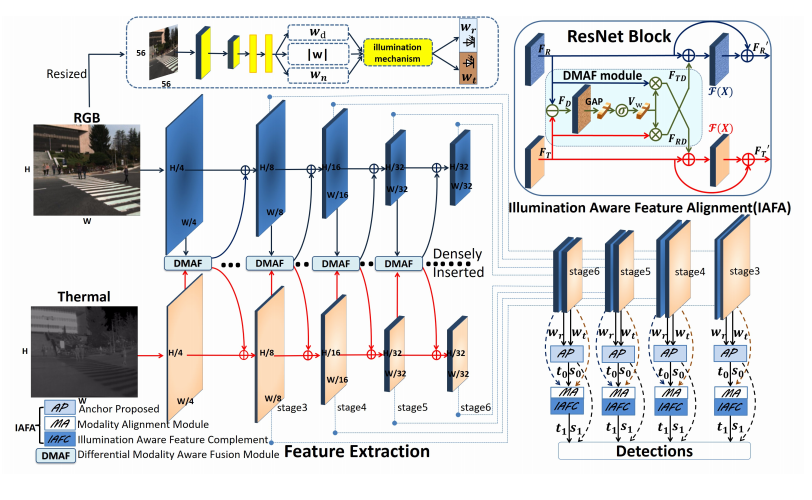

아쉽게도, 존재하는 RGB-Thermal 기반의 detection들은 단순하게 두 feature를 concat하거나 sum-wise 하는 방법을 사용합니다. 해당 방법론에서는 SSD를 기반으로 Feature modality imbalance을 해결하기위한 Differential Modality Aware Fusion(DMAF) module과 illumination modality imbalance을 해결하기 위한 illumination aware feature alignment (IAFA) module을 제안함으로써 modality 불균형 문제를 해소하는 방법을 제안합니다.

Approach

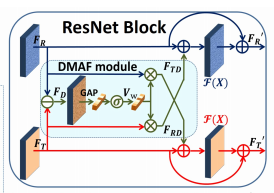

Differential Modality Aware Fusion Module (DMAF)

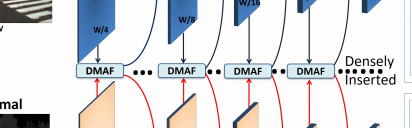

MBNet은 ResNet을 backbone으로 둔 SSD를 기반으로 만들어 졌습니다. 다른 존재하는 RGB-Thermal detector와 동일하게 두 독립적인 backbone을 사용합니다. 또한 Feature imbalance 문제를 해결하기위해서 backbone인 ResNet에 DMAF module을 추가합니다.

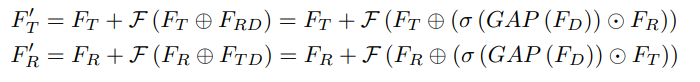

DMAF 모듈의 핵심 아이디어는 채널 별 차등 가중치를 사용하여 다른 모달리티에서 보완 기능을 획득하는 것입니다. modality간 상호 의존성을 명시 적으로 모델링하여 보완 기능의 학습을 향상시켜 다른 modality의 정보 기능에 대한 네트워크 민감도를 높일 수 있도록 만듭니다.

또한 modality간 상호 의존성을 효율적으로 높이기 위해서 ResNet block마다 DMAF 밀집하게 배치합니다.

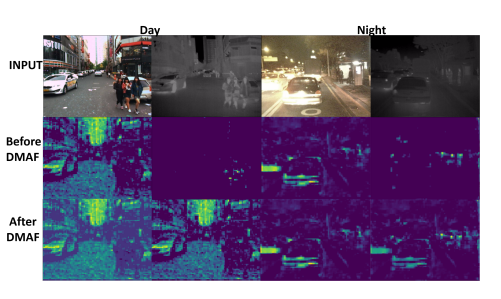

DMAF를 통해 RGB와 Thermal의 특성이 서로 보완적을 전달함으로써 Fig 3과 같이 낮 시간에 Thermal에서는 보이지 않던 차량의 특성이 feature map에 들어난 것을 확인 할 수 있습니다.

++ 저자가 말하길 추가적인 파라미터 없기 때문에 더 효율적이라고 주장합니다.

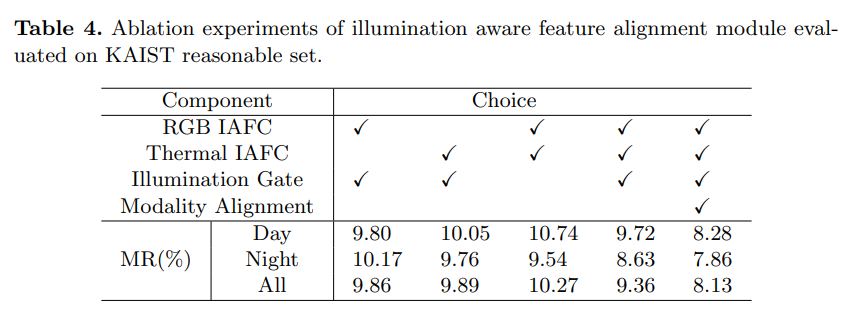

Illumination Aware Feature Alignment Module

해당 모듈은 서로 다른 두 modality의 illumination conditions과 the region proposal stage에서의 정렬을 적응시키는 것에 목적을 둡니다.

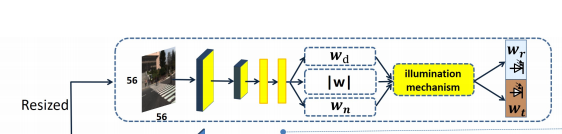

Illumination conditions을 획득하기 위한 tiny network을 사용합니다. 해당 모델을 계산 복잡도를 줄이기 위해서 RGB를 56×56로 resize한 영상을 input으로 합니다.

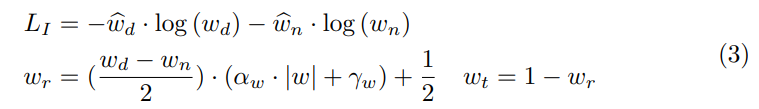

tiny network는 수식 3의 L_I을 이용하여 wd, wn(d:day, n:night)을 예측합니다. 그리고 수식 3(하단)을 이용하여 얻은 값으로 wt, wr(t:thermal, r:RGB)에 대한 weight를 예측합니다. 즉 RGB 예상을 통해 밤과 낮을 예측하고 그에 대한 값을 토대로 RGB와 Thermal에 대한 가중치를 조절하는 방법을 사용함으로써 illumination modality imbalance을 해결합니다.

++ 추가로 Modality Alignment (MA) 모듈을 통해 고정된 convolution kernel로 인한 미정렬을 해결하기위해(동시에 촬영되지 않았다고 가정한다고 합니다.) bilinear interpolation을 사용한다고 합니다.

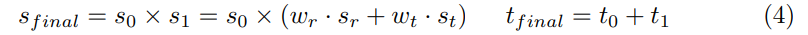

최종적으로 수식 4를 통해 s : score, t : regression offsets을 값을 추론하여 예측 하게 됩니다.

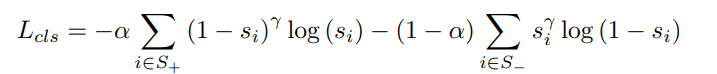

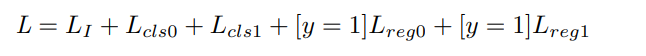

Loss는 위와 같이 score에 cross-entropy를 적용한 classification loss L_cls와 smooth L1을 적용한 regression loss L_reg, 수식 3을 적용한 illumination loss LI들을 합산하여 정의 됩니다.

Experiments