Chao-Yuan Wu , Ross Girshick , Kaiming He

The University of Texas at Austin ,Facebook AI Research (FAIR)

들어가며

이번 논문은 흥미가 있어서 총 2편의 review 통해 전달해 드릴 예정입니다.

1편은 간단한 용어로 전반적으로 intro 느낌으로 논문을 설명하고 2편은 논문의 핵심개념 설명과 함께 실제 work에 적용하기위한 코드까지 볼 예정입니다.

위 논문을 고른 이유는 제가 요즘 video retrieval 에 관심이 있어서 task 를 진행하는 도중 ,video 라는 image와는 다른 매우 큰 dataset을 접하고 이것을 학습하기 위해 어마무시한 시간이 걸린다는 것으로 알고 있었는데,이러한 상황에 굉장히 좋은 솔루션이 될것같아서 고르게 됬습니다.

이 논문의 방법을 한줄로 요약하면

“학습중에 mini-batch shape을 variable하게 해서 정확성을 잃지 않고 더 빠른 훈련을 받는 것”

추가적으로 이 논문을 선택한 이유는 실제로 써볼 수 있을것같아서 입니다.논문에서 그들이 이렇게 말하고 있거든요

우리가 제안한 multi-grid훈련 방법은 간단하고 효과적이다.

1.구현이 쉽고 일반적으로 데이터 로더에 대한 작은 변경만 필요함

2.경험적으로, 그것은 기본 학습 속도 스케줄과 이미 사용되고 있는 하이퍼 파라미터와 함께 작동한다.

3.튜닝이 필요하지 않음

4.또한, 다양한 모델, 데이터셋 및 초기화, 하드웨어 확장 등에 대한 multigrid training은 강건하게 works robustly

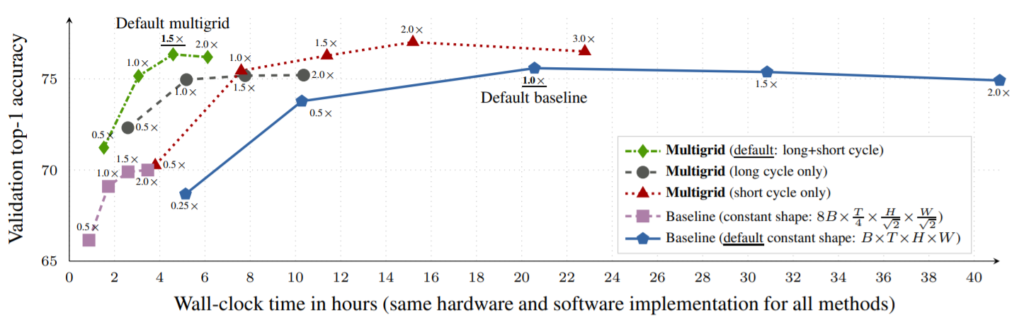

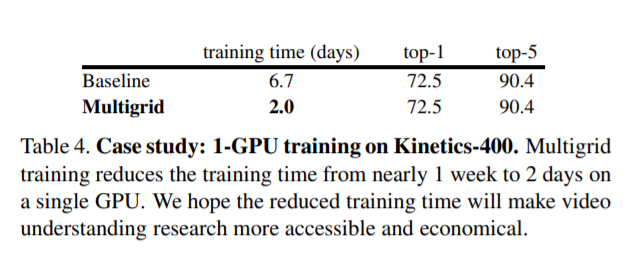

[Kinetics-400 dataset]에 대해서 정확도도 올라가고 시간은 5배 줄었습니다.

intro

일반적으로 3d cnn video model은 mini-batch optimization methods (e.g., SGD)를 사용한다.The mini-batch shape B×T×H×W(minibatch size × number of frames × height × width) 은 일반적으로 학습 하는 동안 변하지 않는다.

T×H×W 치수를 크게 하여 정확도를 향상시킬 수 도있고 ,반대로 적은 수의 프레임 및/또는 공간 크기를 사용하는 동시에 Mini-batch 크기 B를 증가시킬 수 있다.

이는 성능과 속도의 trade-off라고 할 수 있겠다.

본 논문의 중심 개념은 이러한 trade-off을 피하는 것이다.즉, 학습중에 mini-batch shape을 variable하게 해서 정확성을 잃지 않고 더 빠른 훈련을 받는 것이다.이를 위 논문에서 multigrid training 이라 한다.

이논문에서 그들은 multigrid training(제안하는 학습 방식)가similar multi-scale robustness and generalization와 비슷한 것을 관찰했다고 한다.즉 이부분이 성능이 떨어지기는 커녕 오히려 상승한 이유라고 생각한다.

아주 간단히 설명하면 mini-batch shape(BxTxHxW)를 b>B를 항상 만족하도록

sampling 하여 속도를 향상시키는 것이다.

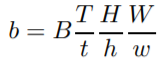

sampling 방법은 1.baseline 2.Long cycles 3.short cycles 4.Long +short cycle이 있는데 처음 성능 그림에서 알수 있듯이 4번이 제일 좋다.

1번은 우리가 하는 방식인 mini batch shape 학습 내내 상수인것이고

2번은 4단계에 걸친 작업을 반복하는 것으로

(8B,T/4,H/root(2),W/root(2))-> (4B,T/2,H/root(2),W/root(2)) -> (2B,T/2,H,W) -> (B,T,H,W)로 진행한다.

3번은 3단계로

(4B,T,H/(2),W/(2)) -> (2B,T,H/ root(2) ,W/ root(2) ) -> (B,T,H,W) 로 진행하고

4번은 2번과 3번의 결합으로 진행한다.

하나의 GPU에서의 학습에대한 리포팅도 따로 되어있는데 ,기존 방법으로 하나의 GPU를 쓸때 1주일 가량 걸리던것을 2일로 단축 시켰음을 알 수 있다.

mini-batch 와 SGD가 혼용되기도 하나요? e.g. SGD라 써있어서요! 그 점이 신기하네요

sampling시에 최소 sample 갯수를 지정해도고 그 갯수 이상으로 샘플링 하여 랜덤성을 주는 새로운 미니배치 방식 인 건가요?

2번째 편도 기대됩니다.

mini batch sgd를 말하는것같습니다.자세한 샘플링 규칙에대해선 2편에서 말씀드리겠습니다^^