ICRA의 Plenary Talk 였던 Self-Supervised Learning & World Models를 이해하기 앞서 영상에서 많이 등장했지만 이해되지 않았던 개념을 정리하고자 합니다.

1. Energy base model (EBM) 접근법

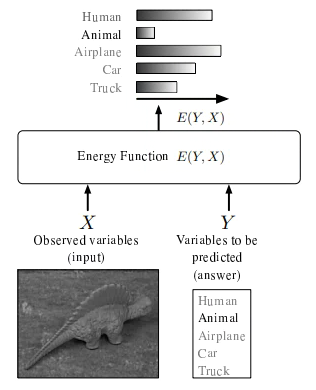

EBM은 x를 y로 분류하는 것이 각 상태 x, y에 따른 에너지를 정의하고 에너지가 낮을수록 안정된(문제에 적합한)모델이 되도록 하는것이다.

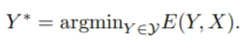

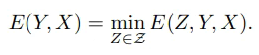

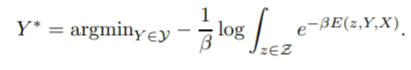

에너지를 나타내는 energy function을 E(Y, X)라 한다. 이는 inference과정에서 최소화되는데, 학습과정에서 최소화되는 Loss function과 구별해야한다. 모델은 X값 입력에 대하여 E(Y, X)가 가장 작은 Y를 output 값으로 한다. 이를 식으로 나타내면 아래와 같다.

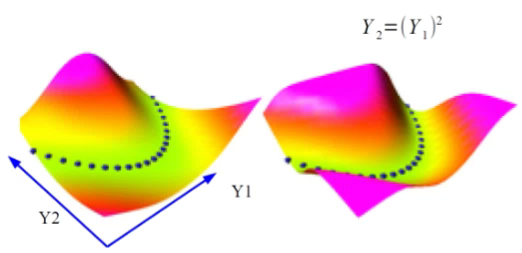

우리는 이러한 energy function 이 (마치 Loss function처럼) 미분가능하여 gradient-based metod를 inference process에서 사용하길 원한다. 하지만 이는 모델에 따라 달라진다. 예를 들어 Y가 이산적이라면 factor graph(i.e. a sum of energy functions (factors) that depend on different subsets of variables)를 사용할 수 있다

2. EBM with latent variables

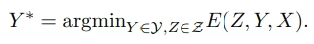

위의 사례처럼 모델에도 입력값 X(문장)와 출력값 Y(내용)가 아닌 hidden variables(언어능력) Z가 판단에 기여한다. 이러한 경우 변수 X와 Y에 대한 추론 프로세스는 hidden variables인 Z의 최소화이다. 이 hidden variables를 latent variables이라 부른다

이를 정의함으로서 추론과정을 두 변수 Y와 Z의 최소화 과정으로 볼 수 있다.

이러한 latent variables는 관측하여 유추할 수 있지만 직접 예측할 수 없는 특성을 다룰 때 유용하다. (예를 들어 얼굴인식 문제에서 사람의 성별이나 얼굴의 방향. 이를 알면 인식 작업이 더욱 쉬워질 수 있다)

3. EBM과 probabilistic models

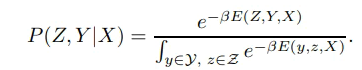

probabilistic models은 EBM의 종류 중 하나이다. 에너지를 정규화되지 않은 음수 로그 확률로 보면 Gibbs-Boltzmann 분포를 사용하여… 다음으로 변환할 수 있다.

이때 Z에 한계를 주면

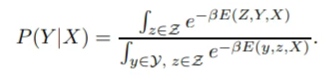

이렇게 Z에 한계를 둔 상태에서 가장 좋은 Y값을 찾아내면

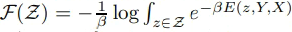

인데 이는 기존의 Energy functon을 다음과 같이 나타낸 것과 같다

이렇게 latent variable의 영향력을 작게 한 것을 Free Energy라 한다.

참고 링크

https://atcold.github.io/pytorch-Deep-Learning/en/week07/07-1/

http://yann.lecun.com/exdb/publis/pdf/lecun-06.pdf

http://jaejunyoo.blogspot.com/2018/02/energy-based-generative-adversarial-nets-1.html

영어를 이해할 수 없다면 위의 문장을 읽을 수 있다. <- 이해할수 있다면 아닌가요?