Abstract

강인한 machine Learning은 매우 중요한 토픽이다. 강인한 machine Learning을 위한 연구분야 중 하나인 black-box adversarial attacks 는 모델의 setting이나 query의 복잡성 때문에 제한되는 부분이 많다.

이 논문은 효율적이고 강인한 black-box adversarial attacks 을 위해 operator splitting(=the alternating direction method of multipliers (ADMM) ) 방식을 기반으로 새로운 framework를 제안한다 (framework는 ADMM의 특성에 의해 Zeroth-order (ZO) optimization 과 Bayesian optimization (BO)이 통합되었다(ZO-ADMM ,BO-ADMM ). 따라서 이는 gradient-free regime에 사용될 수 있다)

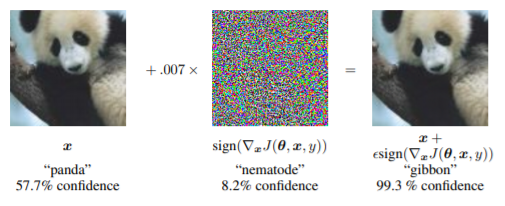

DNNs 은 Adversarial missclassification attack에 취약하다

즉 ,아래의 예시처럼 눈으로는 감지할 수 없는 노이즈에 결과가 달라질 수 있다는 것이다

알 수 없는 노이즈로 panda가 gibbon이 되는

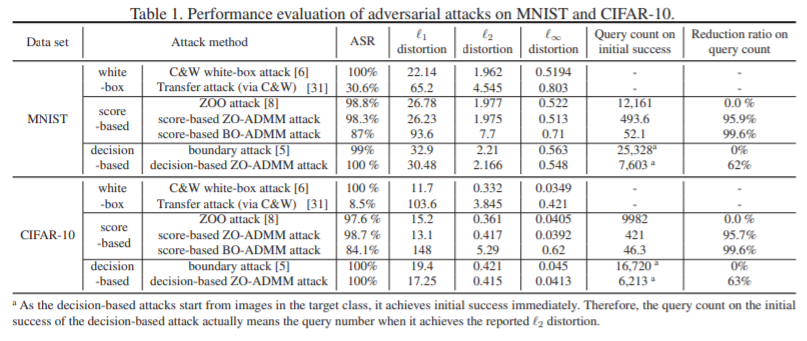

실험 결과

ADMM-based framework 와 various attack methods (white-box(C&W), black-box(ZOO)) 를 비교했다.

오분류의 원리

일반적으로 디저털 이미지는 픽셀당 8 bits로 256단계로 양자화 되어 있다. 기존에 무시되었던 1/256보다 작은 입력은 network의 가중치가 큰 경우 결과에 값이 반영될 수 있는데, network의 Layer가 복잡하면 이러한 작은 변화에도 데이터의 증폭이 발생하고 최종적으로 오분류(Missclassification)이 발생할 수 있다.

Adversarial Attacks 분야 연구가 필요한 이유

AEs(Adversarial Examples)를 이용한 공격사례를 통해 확인할 수 있다.

https://arxiv.org/pdf/1707.08945.pdf

참고 블로그

[링크]