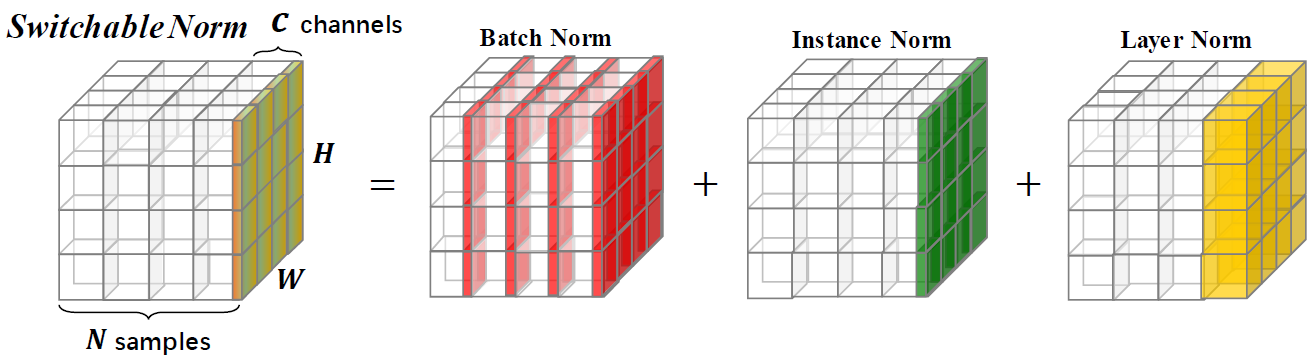

Normalization method 로는 대표적으로 batch normalization, instance normalization, instance normalization, layer normalization, group normalization가 있다. 이러한 normalization은 각자 다른 task를 위해 디자인 되었는데 이 normalizer들의 이점을 결합하여 이용하기 위해 Switchable Normalization(SN) 과 같은 방식이 제안되었다 이 논문은 이와 같은 관점에서 진행 된다 다음의 그림은 SN을 나타내는 그림이다. 다양한 Normalizer를 결합하였다.

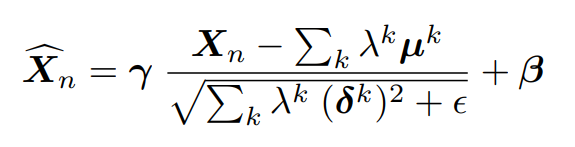

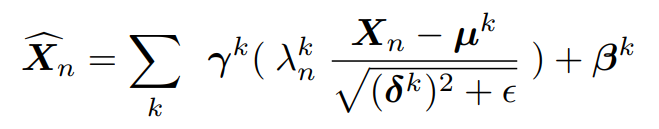

Exemplar Normalization(EN)은 (Switchable Normalization)SN의 확장이라 할 수 있다 실제로 두 수식은 매우 유사하다. 두 수식 (1)과 (2)는 3가지 차이점이 있다.

– mean과 standard deviation을 반영하는 important ratios가 EN에는 없다. EN은 기존의 SN보다 학습 용량이 크기 때문에 학습의 안정성을 보장하기 위함이다.

– 기존의 SN은 important ratios를 normalizers 결합에서 사용하는데 normalized feature map을 결합할 때 사용한다. 이를 통해 SN에서 발생하는 bias를 줄인다

– 여러개의 \beta , \gamma 를 이용하여 feature maps을 re-scale과 re-shift한다